【项目背景】 受到了“yywudao 掌控板 显示图片(三)-- 进阶版处理图片及显示动画”的启发,作者用掌控板播放了“Bad apple”。我也重现了此显示。

顺着作者的想法,既然能播放动画,那应该也有播放视频流,下面是演示视频。

【项目设计】 前期工作请参考:https://mc.dfrobot.com.cn/thread-302527-1-1.html 【准备工作】 电脑要安装: 1、python3(Python3 教程 | 菜鸟教程 )【电脑端】 1、Python获取摄像头图像 注意Python采用代码缩进和冒号( : )来区分代码块之间的层次。 #pip3 install --user opencv-python

#先pip uninstall numpy,确保完全卸载numpy,再pip install --user numpy

def main():

import cv2

import numpy as np

import socket

import time

import binascii

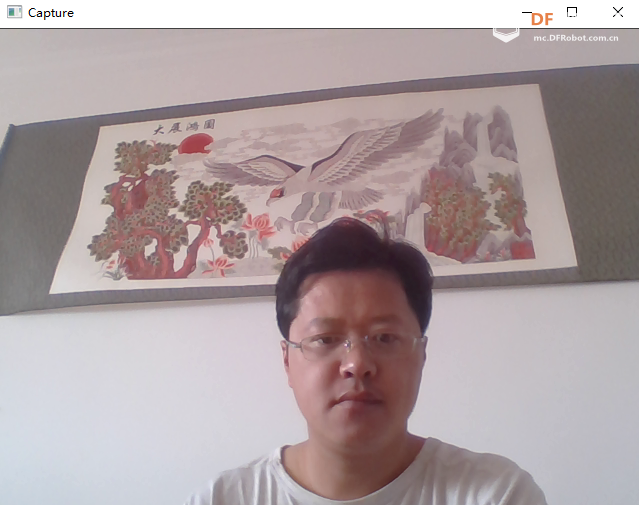

cap = cv2.VideoCapture(0)

while(1): # get a frame and show

ret, frame = cap.read()

if(ret):

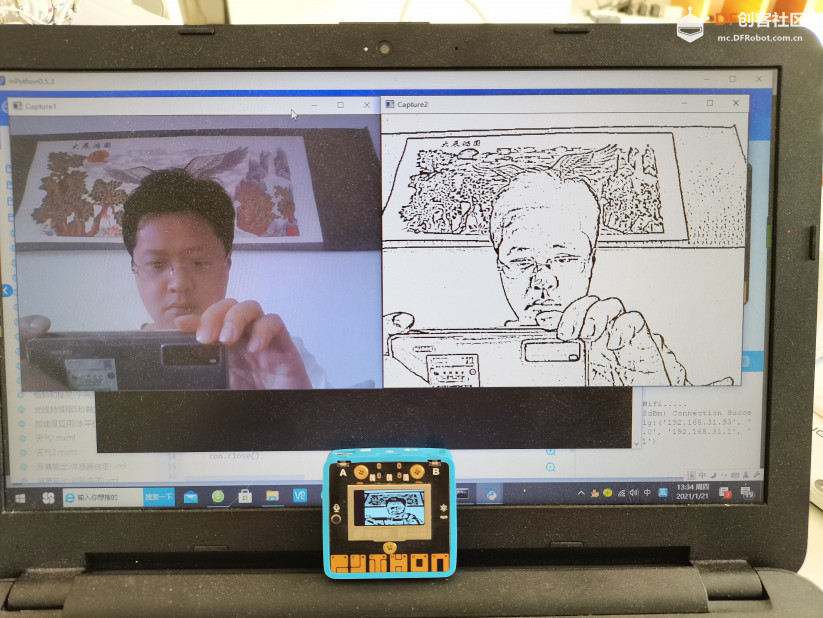

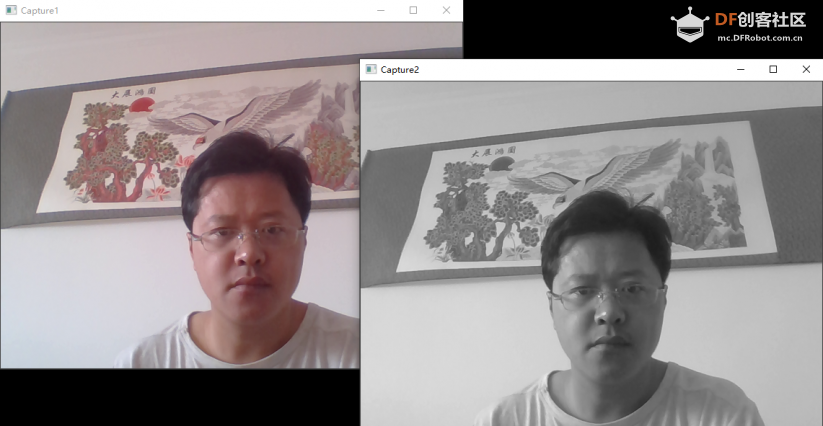

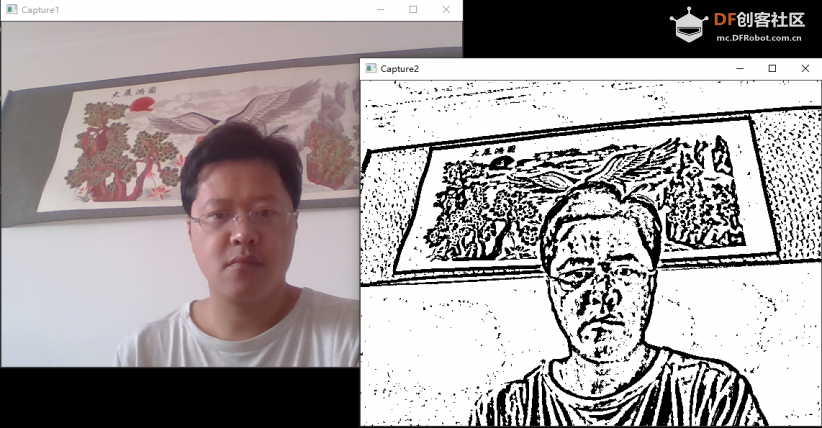

cv2.imshow('Capture', frame) 复制代码 2、图像灰度处理: <font face="微软雅黑"><blockquote>def main():</font> 复制代码 3、图片黑白二值化处理 def main():

import cv2

import numpy as np

import socket

import time

import binascii

cap = cv2.VideoCapture(0)

while(1): # get a frame and show

ret, frame = cap.read()

if(ret):

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

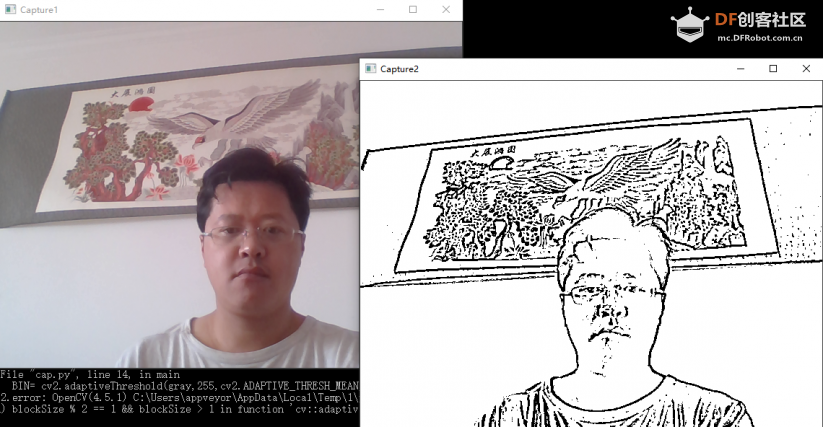

BIN= cv2.adaptiveThreshold(gray,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,11,2)

cv2.imshow('Capture1', frame)

cv2.imshow('Capture2', BIN)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

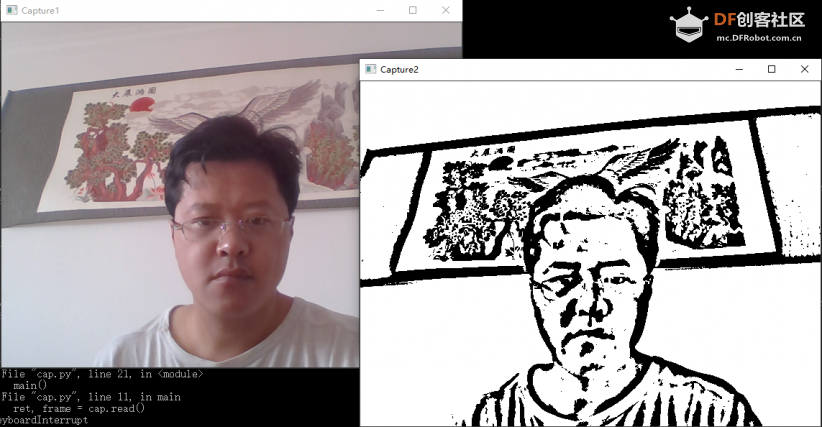

main() 复制代码 void adaptiveThreshold(InputArray src, OutputArray dst, double maxValue,int adaptiveMethod, int thresholdType, int blockSize, double C) 说明下各参数: 可自行调整相应参数: 【数据处理】 1、图像压缩 压缩为128*64(掌控板oled屏幕分辨率) <font face="微软雅黑">def main():

import cv2

import numpy as np

import socket

import time

import binascii

cap = cv2.VideoCapture(0)

W=128

H=64

size = (W,H)

while(1): # get a frame and show

ret, frame = cap.read()

if(ret):

frame = cv2.resize(frame, size)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

BIN= cv2.adaptiveThreshold(gray,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,25,5)

cv2.imshow('Capture1', frame)

cv2.imshow('Capture2', BIN)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

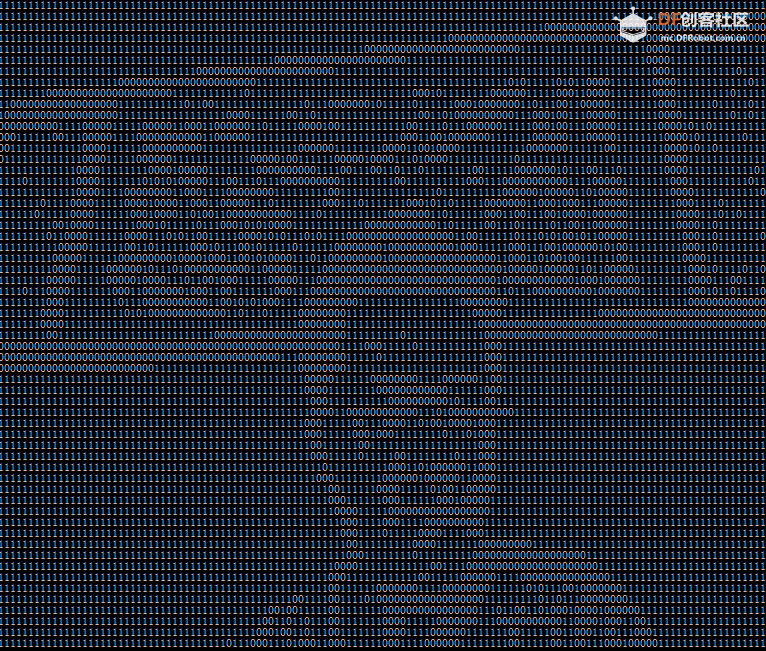

main()</font> 复制代码 2、查看二值化后的数据: def main():

import cv2

import numpy as np

import socket

import time

import binascii

cap = cv2.VideoCapture(0)

W=128

H=64

size = (W,H)

while(1): # get a frame and show

ret, frame = cap.read()

if(ret):

frame = cv2.resize(frame, size)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

BIN= cv2.adaptiveThreshold(gray,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,25,5)

cv2.imshow('Capture1', frame)

cv2.imshow('Capture2', BIN)

for h in range(H):

for w in range(W):

print(BIN[h][w],end="")

print()

#if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

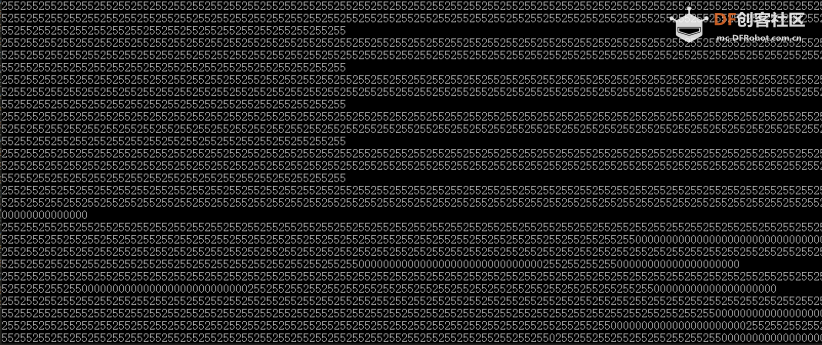

main() 复制代码 从上图看出,大于阈值的都显示为“255”,但“255”不是我想要的,我要的是“1”。 BIN= cv2.adaptiveThreshold(gray, 1 ,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,25,5) 1 ”相对“255”接近于“0”,窗口显示为全黑。所以将图像拷贝一份用来窗口显示,另一份用来进行数据处理。 <font face="微软雅黑">def main():

import cv2

import numpy as np

import socket

import time

import binascii

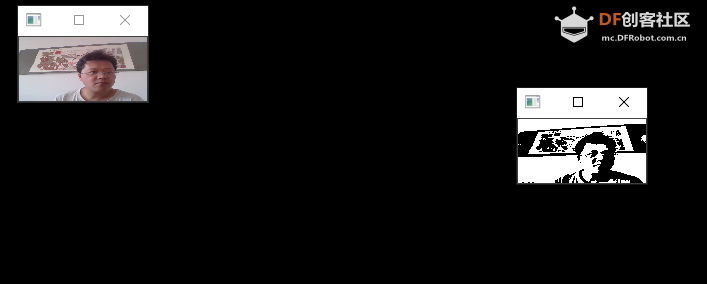

cap = cv2.VideoCapture(0)

W=128

H=64

size = (W,H)

while(1): # get a frame and show

ret, frame1 = cap.read()

if(ret):

frame2=frame1.copy()

frame1 = cv2.resize(frame1, size)

gray1 = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

BIN1= cv2.adaptiveThreshold(gray1,1,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

BIN2= cv2.adaptiveThreshold(gray2,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

cv2.imshow('Capture1', frame2)

cv2.imshow('Capture2', BIN2)

for h in range(H):

for w in range(W):

print(BIN1[h][w],end="")

print()

#if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

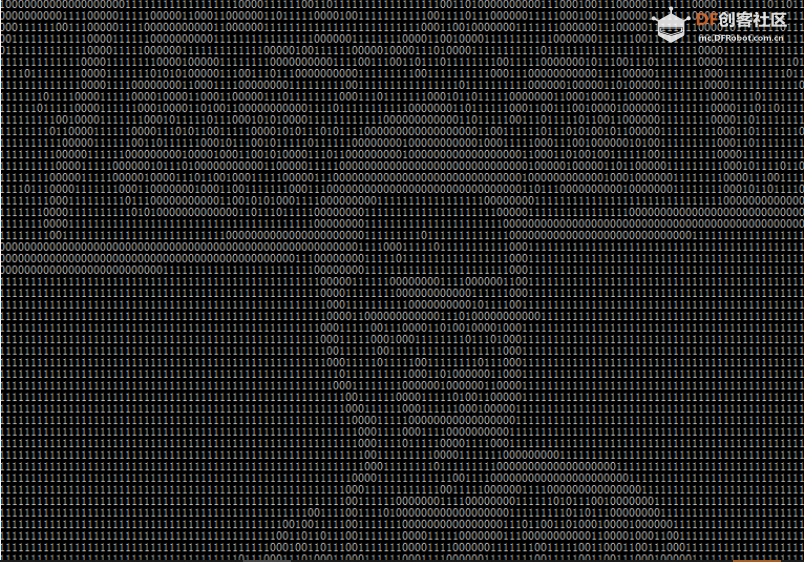

main()</font> 复制代码 "0"和“1”展示自我

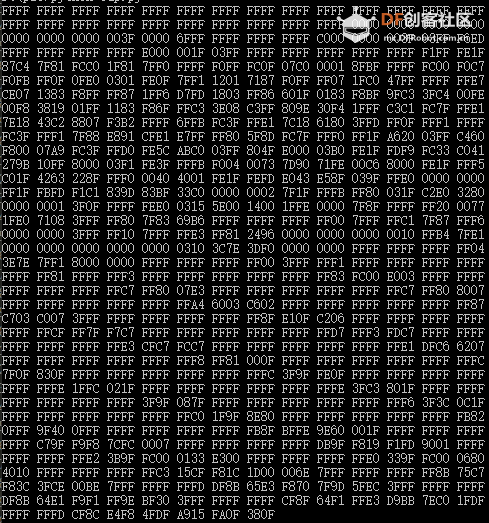

【分析数据】 掌控板能显示“pbm”图像文件,看一下Bad Apple“123.pbm”文件数据内容: 5帧badapple_pbm.zip def main():

import cv2

import numpy as np

import socket

import time

import binascii

cap = cv2.VideoCapture(0)

W=128

H=64

size = (W,H)

val=0

str1=''

while(1): # get a frame and show

ret, frame1 = cap.read()

if(ret):

frame2=frame1.copy()

frame1 = cv2.resize(frame1, size)

gray1 = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

BIN1= cv2.adaptiveThreshold(gray1,1,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

BIN2= cv2.adaptiveThreshold(gray2,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

cv2.imshow('Capture1', frame2)

cv2.imshow('Capture2', BIN2)

str1=""

for h in range(H):

for w in range(0,W,16):

for i in range(4):

val=(int(BIN1[h][w+i*4+0])*8 + int(BIN1[h][w+i*4+1])*4 + int(BIN1[h][w+i*4+2])*2 + int(BIN1[h][w+i*4+3])*1)

if val>=10:

if val == 10:

str1=str1+'A'

if val==11:

str1=str1+'B'

if val==12:

str1=str1+'C'

if val==13:

str1=str1+'D'

if val==14:

str1=str1+'E'

if val==15:

str1=str1+'F'

else:

str1=str1+str(val)

str1=str1+" "

print(str1)

'''for h in range(H):

for w in range(W):

print(BIN1[h][w],end="")

print()'''

#if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

main() 复制代码 【wifi传数据】 下面的是的传送“Bad Apple”pbm文件的电脑端 程序,其中“192.168.31.93 pic\{}.pbm import socket

import time

def main():

for i in range(1,1098):

s=socket.socket(socket.AF_INET, socket.SOCK_STREAM)

s.connect(('<font color="#ff0000">192.168.31.93</font>',10000))

with open(r'<font color="#ff0000">pic\{}.pbm</font>'.format(i),'rb') as f:

#注意到需要用二次 f.readline() 把前二行的数据处理掉。

#数据内容如下:

#第一行:P4,即 PBM 二进制数据

#第三行:图像的像素为88*64

f.readline()

f.readline()

data=f.read()

s.send(data)

print(i)

time.sleep(0.19)

s.close()

if __name__=='__main__':

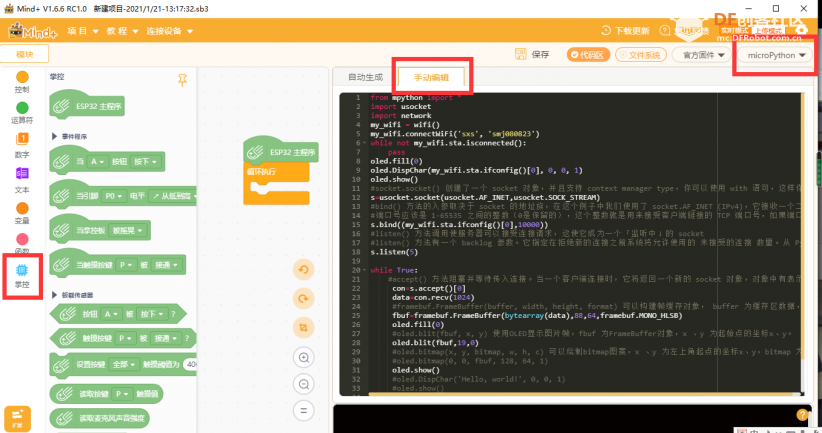

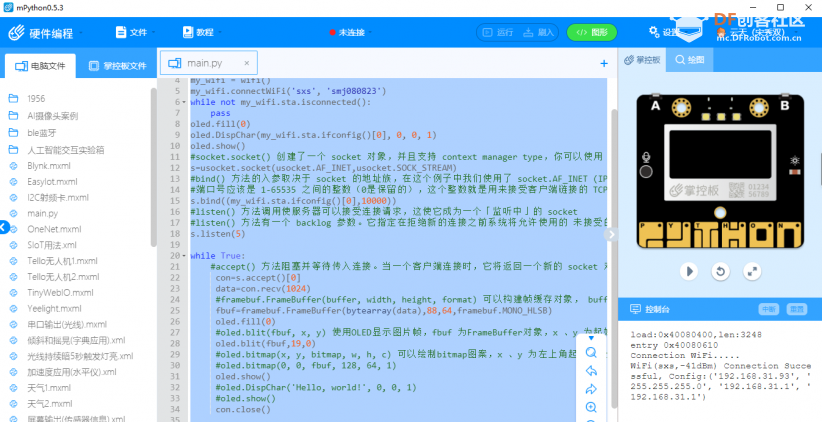

main() 复制代码 【掌控板程序】 from mpython import *

import usocket

import network

my_wifi = wifi()

my_wifi.connectWiFi('###', '##########')

while not my_wifi.sta.isconnected():

pass

oled.fill(0)

oled.DispChar(my_wifi.sta.ifconfig()[0], 0, 0, 1)

oled.show()

#socket.socket() 创建了一个 socket 对象,并且支持 context manager type,你可以使用 with 语句,这样你就不用再手动调用 s.close() 来关闭 socket 了

s=usocket.socket(usocket.AF_INET,usocket.SOCK_STREAM)

#bind() 方法的入参取决于 socket 的地址族,在这个例子中我们使用了 socket.AF_INET (IPv4),它接收一个二元组(host, port)入参

#端口号应该是 1-65535 之间的整数(0是保留的),这个整数就是用来接受客户端链接的 TCP 端口号,如果端口号小于 1024,有的操作系统会要求管理员权限

s.bind((my_wifi.sta.ifconfig()[0],10000))

#listen() 方法调用使服务器可以接受连接请求,这使它成为一个「监听中」的 socket

#listen() 方法有一个 backlog 参数。它指定在拒绝新的连接之前系统将允许使用的 未接受的连接 数量。从 Python 3.5 开始,这是可选参数。如果不指定,Python 将取一个默认值

s.listen(5)

while True:

#accept() 方法阻塞并等待传入连接。当一个客户端连接时,它将返回一个新的 socket 对象,对象中有表示当前连接的 conn 和一个由主机、端口号组成的 IPv4/v6 连接的元组

con=s.accept()[0]

data=con.recv(1024)

#framebuf.FrameBuffer(buffer, width, height, format) 可以构建帧缓存对象, buffer 为缓存区数据,width 为图片宽度,height 为图片高度,format 为FrameBuffer的格式,即对应图片取模时数据输出的扫描模式:framebuf.MONO_HLSB 为水平方向;framebuf.MONO_VLSB 为垂直方向。

fbuf=framebuf.FrameBuffer(bytearray(data),88,64,framebuf.MONO_HLSB)

oled.fill(0)

#oled.blit(fbuf, x, y) 使用OLED显示图片帧,fbuf 为FrameBuffer对象,x 、y 为起始点的坐标x、y。

oled.blit(fbuf,19,0)

oled.show()

con.close()

复制代码 88 ”是“Bad Apple”的,接收实时视频流时要改成“128”,“19 ”改成“0”。【实时视频流显示完整代码】 电脑端 <font face="微软雅黑">def main():

import cv2

import numpy as np

import socket

import time

import binascii

import socket

import time

cap = cv2.VideoCapture(0)

W=128

H=64

size = (W,H)

val=0

str1=''

while(1): # get a frame and show

ret, frame1 = cap.read()

if(ret):

frame2=frame1.copy()

frame1 = cv2.resize(frame1, size)

gray1 = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

BIN1= cv2.adaptiveThreshold(gray1,1,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

BIN2= cv2.adaptiveThreshold(gray2,255,cv2.ADAPTIVE_THRESH_MEAN_C,cv2.THRESH_BINARY,7,3)

cv2.imshow('Capture1', frame2)

cv2.imshow('Capture2', BIN2)

str1=""

for h in range(H):

for w in range(0,W,16):

for i in range(4):

val=(int(BIN1[h][w+i*4+0])*8 + int(BIN1[h][w+i*4+1])*4 + int(BIN1[h][w+i*4+2])*2 + int(BIN1[h][w+i*4+3])*1)

if val>=10:

if val == 10:

str1=str1+'A'

if val==11:

str1=str1+'B'

if val==12:

str1=str1+'C'

if val==13:

str1=str1+'D'

if val==14:

str1=str1+'E'

if val==15:

str1=str1+'F'

else:

str1=str1+str(val)

str1=str1+" "

#print(str1)

s=socket.socket(socket.AF_INET, socket.SOCK_STREAM)

s.connect(('192.168.31.93',10000))

s.send(bytearray.fromhex(str1))

time.sleep(0.19)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

if __name__=='__main__':

main()</font> 复制代码 【源文件】 这里使用代码格式,总是去掉我的缩进空格,Python 采用代码缩进和冒号( : )来区分代码块之间的层次。所以附上源文件,我很厚道。 掌控监视器.zip 【直播协议 】 一、RTMP、RTSP、HTTP协议 二、传送RTMP视频流 rtmp://58.200.131.2:1935/livetv/cctv1 cctv1综合

rtmp://58.200.131.2:1935/livetv/cctv2 cctv2财经

rtmp://58.200.131.2:1935/livetv/cctv3 cctv3综艺

rtmp://58.200.131.2:1935/livetv/cctv4 cctv4中文国际

rtmp://58.200.131.2:1935/livetv/cctv5 cctv5体育 ( 测试有效 )

rtmp://58.200.131.2:1935/livetv/cctv6 cctv6电影

......后边到cctvn自己测-----

代码只需修改: cap = cv2.VideoCapture(0)为 cap = cv2.VideoCapture(‘rtmp://58.200.131.2:1935/livetv/cctv5’),网速不好,会有些卡顿。同时我没有修改time.sleep(0.19),大家可以改小一些,如time.sleep(0.04),效果会更好。

【本地视频】

代码修改: cap = cv2.VideoCapture(0)为 cap = cv2.VideoCapture(‘CCTV.mp4 ’),‘CCTV.mp4 ’视频文件最好与代码文件放在一个目录下。同时我没有修改time.sleep(0.19),大家可以改小一些,如time.sleep(0.04),效果会更好。

【设想计划】

把电脑换成树莓派,做为服务器,向掌控板传送图像。

5帧badapple_pbm.zip

5帧badapple_pbm.zip

掌控监视器.zip

掌控监视器.zip 沪公网安备31011502402448

沪公网安备31011502402448