|

18626| 1

|

[入门] 在 iterm2 中使用本地大语言模型 ollama 进行工作 |

|

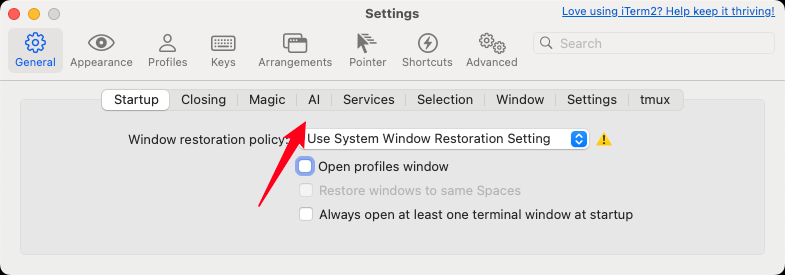

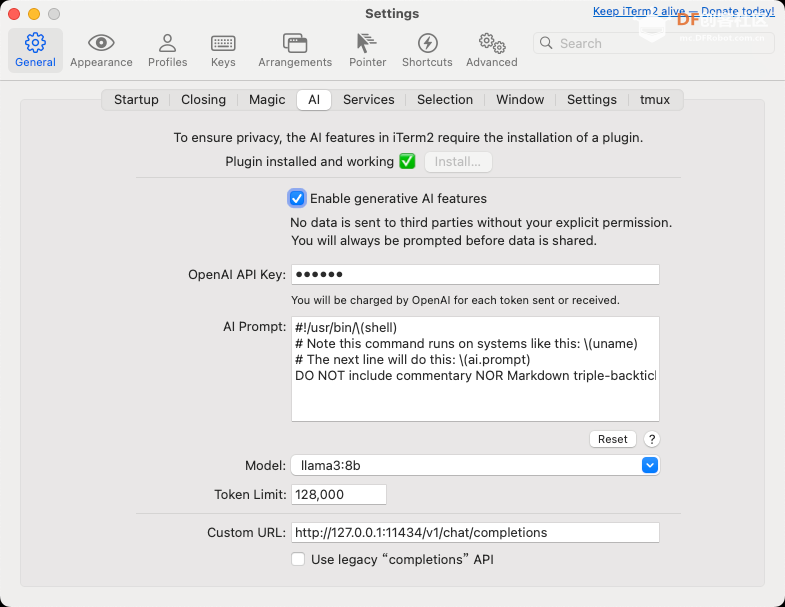

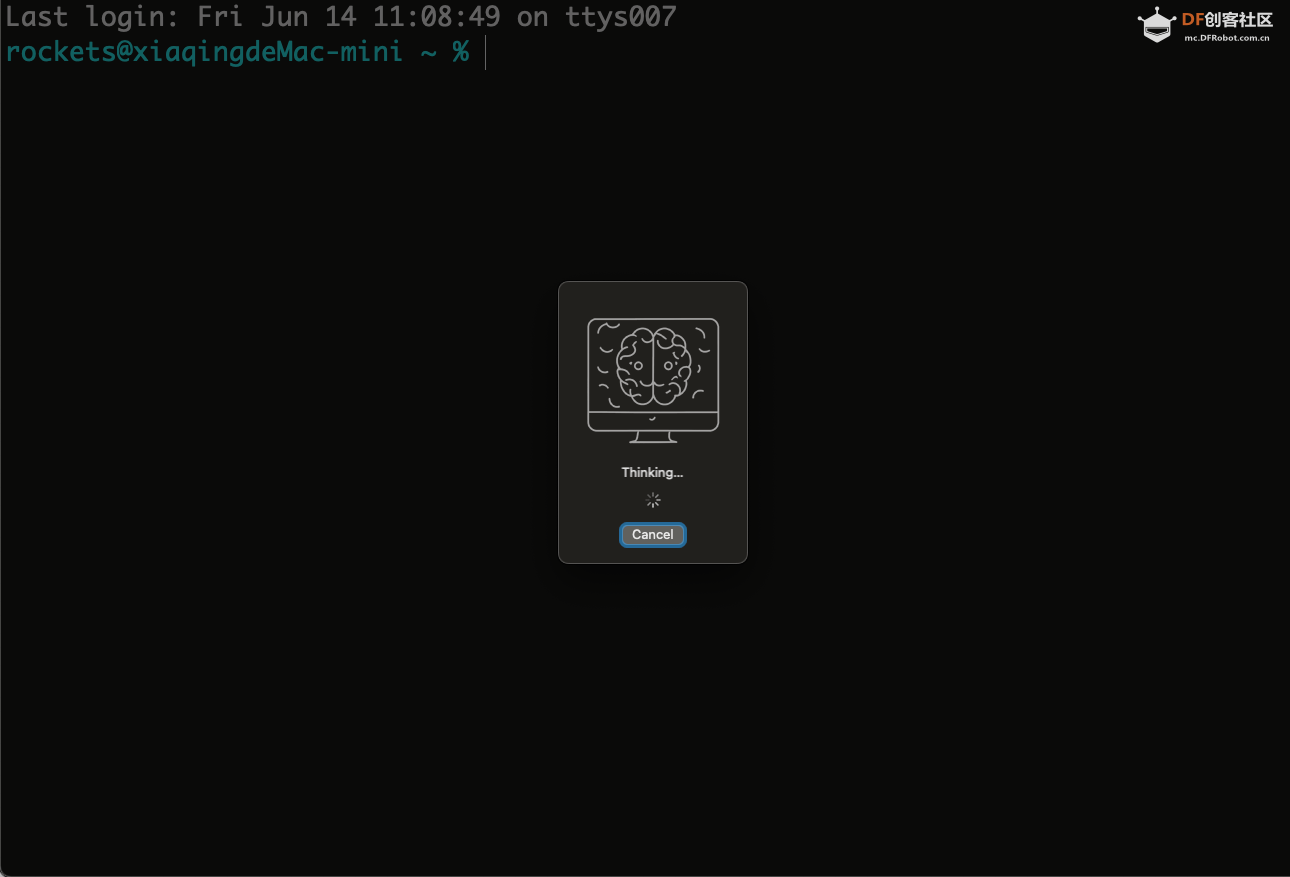

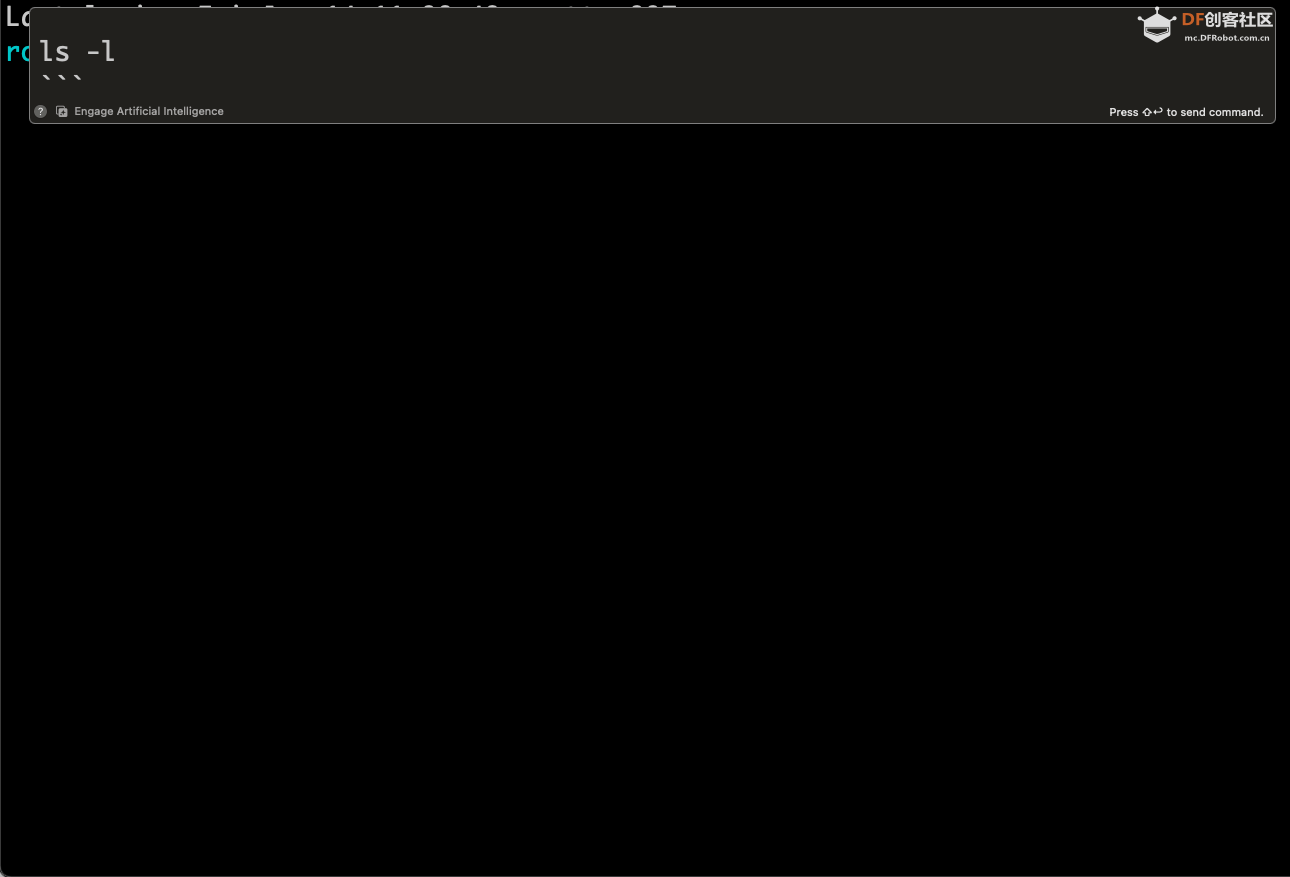

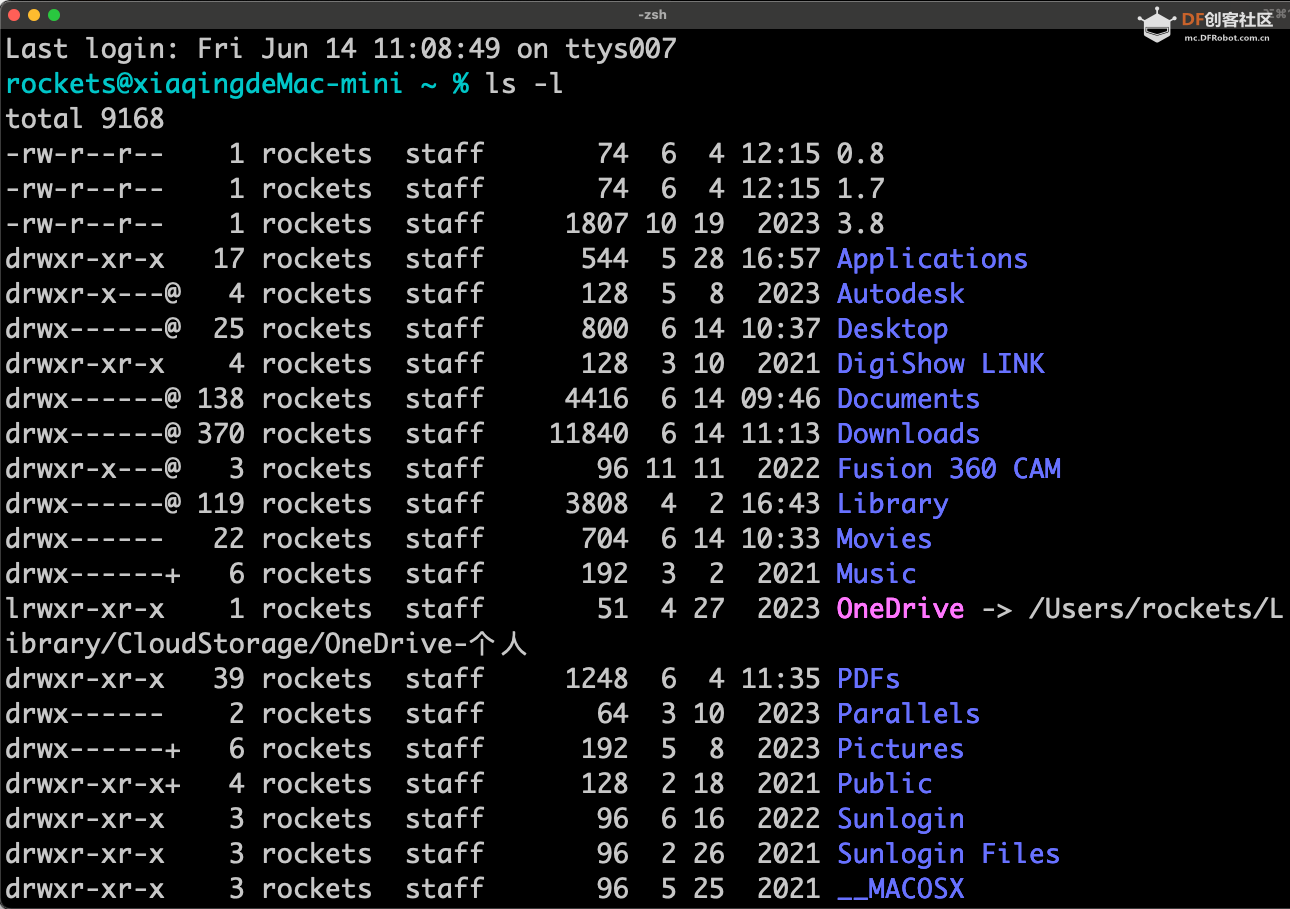

本帖最后由 微笑的rockets 于 2024-6-14 12:31 编辑 item2 是 mac 系统终端最好的替代品。 最近 iterm2 更新到了 3.4  最新版本的 iterm2 支持了使用 ai 辅助使用。之前 3.3 版本只能使用 openai 的接口。3.4 版本可以使用非 openai 的接口。 我们就来看下怎么设置  打开终端后可以通过CMD+,打开设置 打开终端后可以通过CMD+,打开设置 打开 ai 选项卡  注意,iterm 2为了隐私,将原来的集成方式改为插件方式。 接下来就是安装插件。先下载插件。插件为 zip 文件,解压缩后放在应用目录下就好了。  安装好插件后,就可以设置ollama 的使用。 OpenAI API Key 可以随便填,或者你可以填 ollama AI Prompt需要根据选择的模型调整。经过测试,我使用了: Model 可以根据你机器上安装的 ollama 模型选择,我这里选择了llama3:8b Cutstom URL填入http://127.0.0.1:11434/v1/chat/completions 关闭选项卡就可以使用了 在终端里就可以使用了。 用 CMD+y 就可以调出窗口,就可以在窗口输入需求,大语言模型就可以根据自然语言来给出命令。  然后按 shift+回车就可以启动大语言模型的使用了。  一开始的时候,会需要一点时间加载模型。  转换成的命令就出现了。用shift+回车就可以执行这条命令了。  这样 ollama 就可以在 iterm2 部署好了。 参考资料: https://iterm2.com/version3.html https://iterm2.com/ai-plugin.html |

沪公网安备31011502402448

沪公网安备31011502402448© 2013-2026 Comsenz Inc. Powered by Discuz! X3.4 Licensed