|

24696| 4

|

[项目分享] 【人工智能】-Mind+通过AI扩展库使用 ollama本地大语言模型 |

|

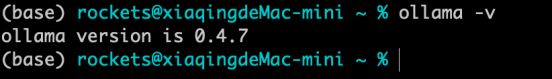

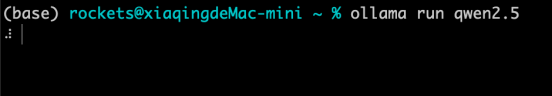

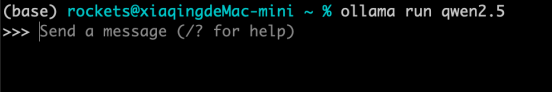

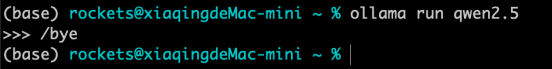

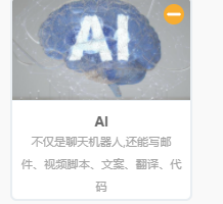

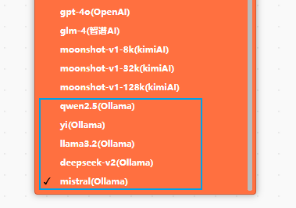

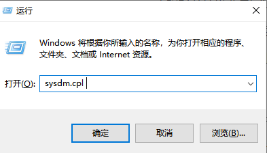

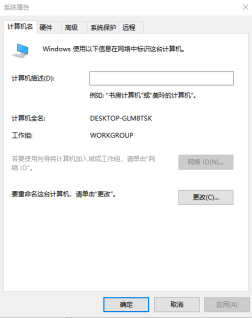

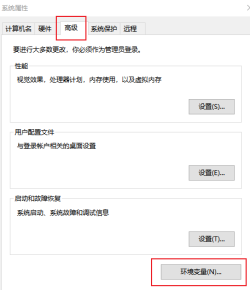

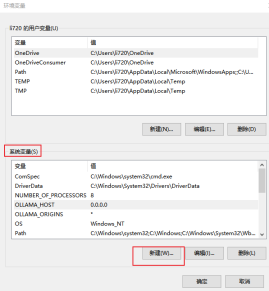

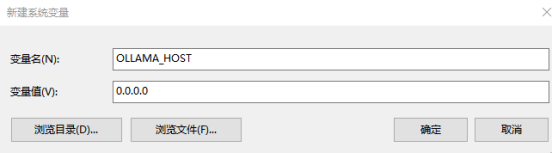

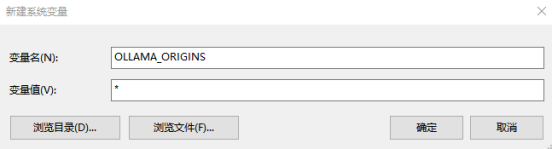

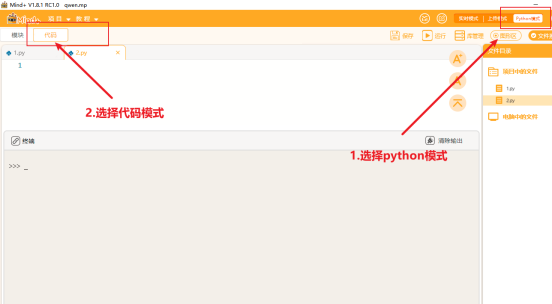

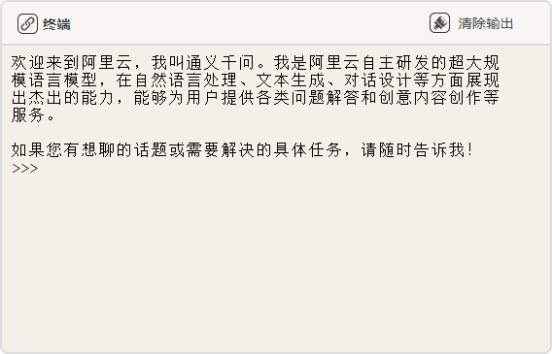

本帖最后由 loria 于 2025-1-17 15:09 编辑 1.Ollama是什么 Ollama是一个开源的大语言模型(LLM)服务工具,用于简化在本地运行大语言模型、降低大语言模型的门槛,帮助用户够在本地环境快速实验、管理和部署最新大语言模型,包括如Qwen2、Llama3、Phi3、Gemma2等开源的大型语言模型。 2.如何安装Ollama 我们可以在Ollama的官网首页直接下载。打开 www.ollama.com 的网站,下载并安装 ollama 软件  下载完 ollama 后,点击运行ollama.exe,在 windows 中可以用 windows+R快捷键可以打开对话框,在对话框中输入 cmd进入终端,然后输入ollama -v,确认安装完成  3.下载模型到本地使用 Ollama支持通过Ollama远程仓库下载LLM到本地.接下来,我们以qwen2.5 千问模型为例展示如何通过终端下载并使用模型。 在终端使用 【ollama run 模型名称:参数规格】指令,可以下载相应规格参数的模型。保持ollama.exe在后台运行,打开终端,输入 ollama run qwen2.5,代表从 Ollama 仓库下载qwen2.5大模型的2.5b参数规格大模型文件到本地磁盘 如下所示,这个命令可以下载 qwen2.5 千问模型并运行。  下载完成后,就可以看到对话界面,到这里我们就能通过终端对话界面进行对话了。  输入/bye就可以退出对话界面。  如果需要使用其他模型,可以在https://ollama.com/search中根据需要查找需要的模型进行下载,目前推荐的7b 左右的模型LLaMA3.2、qwen2.5、deepseek-v2、yi和mistral。 4.通过API调用本地模型 相信通过前面的步骤,你已经学会通过通过Ollama去下载和管理本地大语言模型。如果你感觉这种通过终端界面与大模型对话的体验感不是很好的话,我们可以将Ollama集成到Python应用中,通过API接口的方式实现与本地大语言模型的对话。 在图形化编程软件Mind+中,提供了AI扩展库,提供了简便的方式来调用和操作有关大语言模型的API,其中包括Ollama管理的本地模型,例如qwen2.5、yi、deepseek-v2和mistral等   接下来我们将通过简单的两步实现使用Mind+的AI扩展库通过API调用Ollama管理的本地模型。 (1)配置系统环境变量 使用win+R快捷键打开对话框,输出 sysdm.cpl ,点击确定,进入系统属性。   在系统属性中,选择高级,点击“环境变量”,在系统环境变量中,选择新建变量。   设置新建的变量名为“OLLAMA_HOST”,变量值为' 0.0.0.0 '。这里是将Ollama服务监听的网络地址设置为0.0.0.0  再新建一个系统变量,变量名为"OLLAMA_ORIGINS",变量值为 ' * '。这里是将HTTP客户端请求来源设置为不受限制。  (2)安装Pythony库openai 下载及安装Mind+软件,下载地址:http://www.mindplus.cc。下载完成后i,打开Mind+软件,切换成”python“模式下的代码模式。  点击库管理,选择国内镜像源,输入”pip install openai“,完成openai库的安装。  在”扩展“中选择”用户库“,直接复制该链接,gitee:https://gitee.com/chenqi1233/ext-AI   接下来,我们就能通过简单的图形化指令实现通过API使用本地大模型。由于在步骤3中我们已经将qwen2.5模型下载到本地,这里我们可以直接选择该模型通过API方式来调用。(确保Ollama软件保持后台运行)代码示例如下。   参考文档 除了Ollama管理的本地模型外,Mind+扩展库AI库集成了市面上常用的大语言模型工具如OpenAI模型、智谱AI、kimiAI等,并统一采用OpenAI API 格式,如果感兴趣,可以点击以下链接查看使用详情,Mind+扩展库AI库的使用教程:https://mc.dfrobot.com.cn/thread-322967-1-1.html |

| 前几天用一切正常,都调试完毕有输出了,但今天用就是“ModuleNotFoundError: No module named 'openai'”,再装Openai也装不进去(我肯定前几天是装好的),这是怎么回事呢 |

编辑选择奖

编辑选择奖

沪公网安备31011502402448

沪公网安备31011502402448© 2013-2026 Comsenz Inc. Powered by Discuz! X3.4 Licensed