|

5868| 0

|

机器视觉新突破,MIT新算法优化机器人视觉 |

|

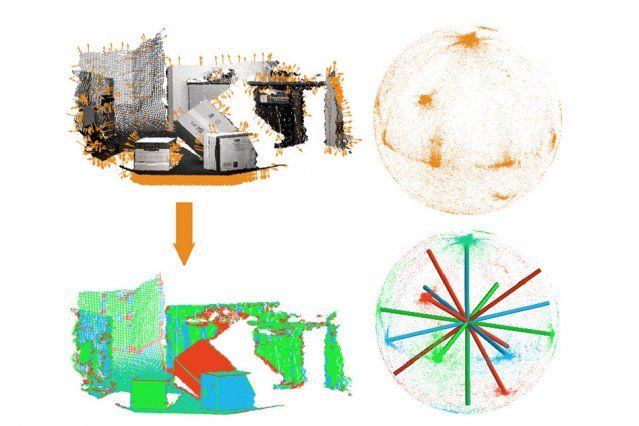

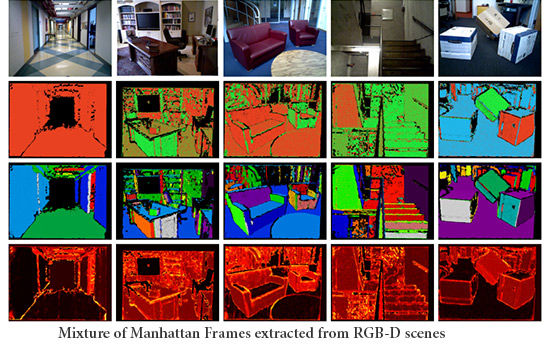

在过去的18个月中,机器视觉取得了很多突破性的进展,2014甚至有可能成为机器视觉之年。 当然,大自然母亲赐予人类视觉能力的时间已超过500万年,要想超过她的杰作还没那么容易。然而,令人惊奇的是,在将Kinect(体感)引机器人世界后,机器视觉的开发者们好像受到了启发,开始不停涌现新的创意与灵感。 在这随后的三四年,特别是近18个月以来,机器视觉取得了一些非常重大的进展——当然,这可能也只是一个巧合。 但现在几乎可以肯定,将来如果没有合适视觉系统的机器人将会给淘汰,就好比生物进化时的物竞天择。 麻省理工的Julian Straub在提升视觉系统能力方面,有其独到之处,其开发了一套新的确定物体方位的算法,将帮助机器人导航以及理解场景。 MIT:假设你在穿越大城市某个陌生的地方,你需要利用周围的摩天大楼来作为你的参考物。但是城市道路并非全都是直线,有可能你会失去你的路标,当它们重新出现时,如果你还想用它们来导航,你就必须判断你眼前的是否是之前的同一栋楼,以及你需要判断与其的相对位置。  这种判断对于人类来说非常简单,但是对于电脑就不是那么容易了。然而MIT的研究人员即将在6月举行的IEEE计算机视觉与模式识别大会上发表的一种通过在3D场景里识别主方向的新算法将改变这种情况。新算法同时还将简化场景识别的问题,这是计算机视觉研究领域的一个主要挑战。 新算法主要用于帮助机器人在陌生建筑物里的导航,而不是用于陌生城市的行驶,但是原理是相同的。该技术通过识别给定场景里的主要方位,并用嵌入在球体里一组被称为曼哈顿帧(Manhattan Frames)的轴来表示。当机器人移动时,它开始作用,观察球体旋转的相对方向,并给出其和这些轴之间的相对方位。不管什么时候,当它想重新定位时,它知道标记物的哪些面正对它,使它们更容易识别。 MIT机器视觉新算法优化机器人视觉 事实证明,这个算法同样也大幅简化了平面分割的问题,或者是判断视场里的元素在哪个平面,以及什么深度。平面分割可以让计算机建立视场中物体的四方的3D模型,并且反过来匹配存储的已知模型。 麻省理工电子工程和计算机科学的毕业生Julian Straub是这篇论文的第一作者,其他参与的人包括他的导师,麻省理工计算机科学和人工智能实验室的资深科学家John Fisher,机械和海洋工程教授John Leonard,以及Fisher感知学习和推理团队的Oren Freifeld 和 Guy Rosman。 新算法适用于Microsoft Kinect或者激光测距仪收集的3D数据。首先,使用已有的程序,算法估算场景里大量的独立点的方位。这些方位代表球体表面上的点,每个点都定义了相对于球体中心的唯一角度。由于初始方位估算并不精确,球体上的点形成了松散的簇群,很难辨认。通过初始方位估计不确定性的统计信息,算法会将曼哈顿帧与球体上的点匹配。 其基本思想和回归分析类似,寻找最接近这些散点的直线。但是由于球体的几何形状,这是很复杂的。“最经典的统计是基于线性和欧式距离,你可以取两个点,将它们连起来,再除以二,这就是均分。”Freifeld说。“但是当你面对的是非线性的空间时,你还是这样来平均,你可能就落在了空间外。” MIT机器视觉新算法优化机器人视觉(机器人网) 例如,测量地理距离。“假设你在东京,我在纽约,”Freifeld继续说,“我们之间距离的中点不是在地球内部,而是在地球表面的某一点。”新算法的关键之一就是将这些场景的图形信息包含进统计推理中。 理论上,通过数百个不同的曼哈顿框架可以精确地逼近这些点,但是这样将使模型太复杂而无法使用。算法的另一方面是用于衡量表示接近精度的帧数的成本函数。算法开始时使用固定的帧数——3到10之间的某个数,取决于场景的复杂程度,然后在不影响整体成本函数的情况下减少帧数。  由此产生的曼哈顿帧集可能不能描绘彼此偏差很小的物体间的差异,但是这些差异对于导航系统来说并没有太大的用处。“例如你在房间里走路,”Fisher说,“你并不需要建立精确的环境模型。你只是抓取一些松散的统计信息,能够让你完成你的任务,并且不会给椅子或者是类似的东西绊倒。” 只要一套曼哈顿帧决定后,平面分割的问题就变得简单多了。那些在视场里不占据太多空间的物体,例如小的,远的或者是被遮挡的,通常会对现有的平面分割造成麻烦,因为它们产生很少的深度信息,它们的方位不能被可靠推理。但是如果问题时只是选择其中少数几个可能的方位,而不是潜在的无穷中的一个,处理起来就变得更容易。 原文转载自:http://www.roboticschina.com/ART ... ick_from=8800108028,9531100998,2014-04-18,RTCOL,NEWSLETTER |

沪公网安备31011502402448

沪公网安备31011502402448© 2013-2026 Comsenz Inc. Powered by Discuz! X3.4 Licensed