|

81| 5

|

[试用测评] 【花雕动手做】AI 视觉传感器二哈识图2之识别物体数据 |

|

一、相关知识点 1、HUSKYLENS 2(二哈识图2)是DFRobot推出的新一代AI视觉传感器,搭载6TOPS算力的Kendryte K230双核RISC-V芯片,集成1GB LPDDR4内存与8GB存储,支持人脸识别、物体检测、姿态估计等20余种预置AI模型,同时允许用户通过自训练模型部署实现定制化识别 。其硬件配置包括200万像素摄像头、2.4英寸触摸屏、可更换镜头模组(支持显微/夜视)及RGB补光灯,搭配UART/I2C接口可无缝连接Arduino、树莓派等开发板,实现实时图传与多模态交互。内置MCP服务打通本地视觉与大模型能力,例如识别午餐图片后可生成膳食建议,而模型广场提供车牌识别、跌倒检测等垂直领域即用型方案。作为教育利器,它已融入《中小学人工智能通识教育指南》课程体系,通过Mind+图形化编程工具降低AI开发门槛,助力创客教育与STEAM实践。  2、行空板 K10 是一款专为中小学信息科技教学和创客项目设计的国产 AIoT 开发板,以 ESP32-S3 为核心,高度集成 2.8 英寸全彩 LCD 屏、摄像头、双麦扬声器、WiFi 蓝牙模块及温湿度、光线、加速度等多种传感器,无需额外配件即可实现离线语音识别(支持 200 词库)、人脸识别、二维码读取、物联网联动等功能,支持 Mind + 图形化编程与 MicroPython 代码编程,兼顾入门便捷性与功能扩展性,丰富的扩展接口还能连接外部传感器、执行器,轻松落地 AI、物联网类创意项目,是编程学习与科创实践的高性价比选择。  3、Mind + 是 DFRobot 旗下蘑菇云科创教育团队研发的、拥有自主知识产权的国产青少年编程软件,它兼容 Scratch3.0,既支持零基础学习者拖拽图形化积木编程,也能切换至 Python/C/C++ 代码编程,且积木可自动转换为对应代码助力进阶学习,同时适配行空板M10\ K10、Arduino、micro:bit 等众多主流开源硬件与上百种电子模块,集成图像识别、语音识别等 AI 功能及物联网开发能力,还搭配实时交互、程序烧录脱机运行等模式与丰富教学案例,适配校内外编程教学、创客项目及竞赛等场景,是兼顾低入门门槛与高拓展性的科创教育工具。 二、硬件连接 准备材料 行空板K10 x 1 HUSKYLENS 2 x 1 USB数据线 x 2 4pin连接线(或杜邦线)x 1 准备一根USB数据线和一根4Pin白色硅胶线。使用USB数据线连接电脑与行空板K10,使用4Pin黑胶先连接行空板K10与HuskyLens 2,再使用额外的USB数据线n连接示意图如下连接HUSKYLENS 2的Type-C接口与电源,为HUSKYLENS 2进行额外供电。接线图可参考下图。    |

|

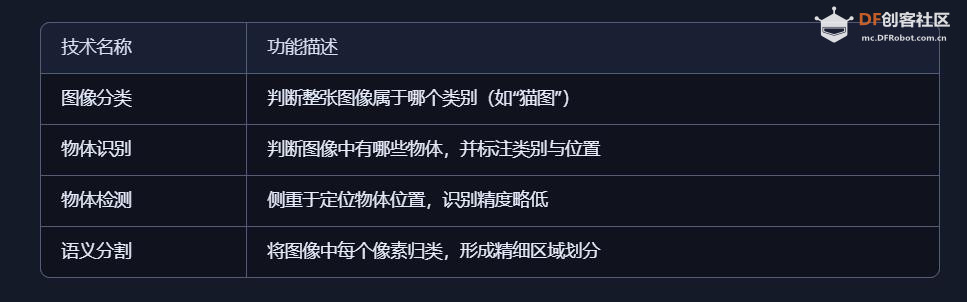

三、物体识别(Object Recognition)是计算机视觉领域中的核心技术之一,其主要目标是:让计算机或智能设备能够“看懂”图像中的物体,并准确判断其类别、位置和属性。物体识别是让机器“看懂世界”的关键一步。它是人工智能“视觉理解”的基础,广泛应用于自动驾驶、安防监控、智能机器人、图像搜索、增强现实等场景。 (1)物体识别的基本定义 物体识别是指: 通过图像处理与深度学习算法,自动识别图像或视频中存在的物体,并标注其类别(如人、车、猫)与位置(如边框、坐标)。 它不仅判断“这是什么”,还能指出“它在哪里”。 (2)物体识别的关键流程 图像采集:通过摄像头或图像文件获取视觉数据。 特征提取:分析图像中的颜色、纹理、形状、边缘等特征。 分类判断:使用训练好的模型判断物体属于哪个类别。 位置定位:标出物体在图像中的具体位置(如边框或关键点)。 结果输出:返回识别结果供系统使用或用户查看。 (3)与相关技术的区别  (4)应用场景举例 自动驾驶识别行人、车辆、交通标志 安防系统识别可疑人物或物品 手机相册自动分类人物、动物、风景 教育实验识别颜色球、标签、手势等 智能零售识别商品并自动结算 机器人识别目标物体并进行抓取或互动 (5)常见识别模型与算法  (6)相关场景    |

|

四、【花雕动手做】HUSKYLENS 2 AI视觉传感器之识别物体输出相关数据 可识别HuskyLens 2视野内的物体(须是可识别的80种固定类别物体,详见物体识别功能介绍),获取物体相关数据,可以读取的数据有:画面中可识别物体的总数、靠近HuskyLens 2摄像头画面中心的物体ID号、检测到的第一个物体。识别物体后,可获取画面中指定物体的相关数据。例如,判断某个指定的物体是否在画面中、指定物体的名称、可获取画面中指定同类物体的数量,当画面中出现多个同类物体时,可指定获取其中某个物体的相关参数,包括名称、X/Y坐标、宽度、高度。 1、实际测试的几个范本     |

2、测试实验代码代码解读和架构分析: 系统架构与核心技术栈 1. 硬件系统架构 text ┌─────────────────┐ I2C通信 ┌──────────────────┐ │ ESP32-S3 │◄─────────────►│ HUSKYLENS 2 │ │ (主控制器) │ │ (AI视觉传感器) │ │ • 240MHz │ │ • Kendryte K210│ │ • 双核处理器 │ │ • 深度学习加速│ └─────────────────┘ └──────────────────┘ │ │ 显示接口 ▼ ┌─────────────────┐ │ 行空板K10屏幕 │ │ (用户界面) │ └─────────────────┘ 2. 软件架构层次 text 应用层: 物体识别显示系统 ↓ 控制层: 双重查询策略(中心优先 + ID定向) ↓ 算法层: HUSKYLENS物体识别引擎 ↓ ├── 目标检测(YOLO/SSD) 驱动层: I2C协议 + 显示驱动 ├── 特征提取(CNN) ↓ └── 非极大值抑制 硬件层: 摄像头 + AI芯片 + 显示屏 代码执行流程深度分析 1. 初始化阶段技术细节 cpp 关键技术特性: 硬件抽象:统一的API封装底层硬件差异 连接可靠性:自动重试确保传感器可用性 显示优化:双缓冲消除屏幕闪烁 2. 主循环实时处理流水线 cpp 物体识别核心技术解析 1. HUSKYLENS物体识别算法流程 text 图像采集(OV摄像头) ↓ 图像预处理(归一化、尺寸调整) ↓ 神经网络前向推理(MobileNet-SSD/YOLO) ↓ 边界框回归(坐标预测) ↓ 置信度过滤(阈值0.5以上) ↓ 非极大值抑制(去除重叠框) ↓ 类别解码(输出物体标签) ↓ 结果序列化(I2C数据包) 2. 深度学习模型特性 支持的物体类别(典型): cpp 模型性能指标: 推理速度:~30ms (K210 @ 400MHz) 检测精度:mAP ~60% (COCO数据集) 输入分辨率:320x240 / 640x480 支持类别:20-80种常见物体 数据结构与信息架构 1. 物体识别结果数据结构 cpp 2. 双重查询机制技术实现 中心优先查询算法: cpp ID定向查询机制: cpp 实时性能优化策略 1. 20Hz处理周期分析 cpp text ┌─────────────────────────────────────────────┐ │ 图像采集(8ms) │ 神经网络推理(25ms) │ 后处理(5ms) │ ├─────────────────────────────────────────────┤ │ 数据传输(3ms) │ 显示渲染(6ms) │ 系统余量(3ms) │ └─────────────────────────────────────────────┘ 2. 数据处理优化技术 cpp |

测试实验代码 |

沪公网安备31011502402448

沪公网安备31011502402448© 2013-2025 Comsenz Inc. Powered by Discuz! X3.4 Licensed