注:

- 英特尔® System Studio 是一种一体化的跨平台工具套件,旨在简化系统启动流程,并提高英特尔® 平台上系统和物联网设备应用的性能。如果您正在使用采用英特尔® System Studio 的英特尔® OpenVINO™ 工具套件分发版,请前往英特尔® System Studio 入门指南。

- 英特尔® OpenVINO™ 工具套件分发版之前被称为英特尔® 计算机视觉SDK。

- 本指南适用于 Microsoft Windows 10 64 位。关于 Linux OS 的信息和说明,请参阅 Linux 安装指南。

简介

重要提示:

- 本指南中的所有步骤都必须执行,除非另有说明。

- 除下载软件包之外,您还必须安装关联组件并完成配置步骤。

这些步骤都执行之后,安装过程才算完成。

- 安装英特尔® OpenVINO™ 工具套件分发版核心组件

-

安装关联组件:

- 设置环境变量

- 配置模型优化器

- 运行两个用于验证安装的验证脚本

- 可选:

关于英特尔® OpenVINO™ 工具套件分发版

英特尔® OpenVINO™ 工具套件分发版支持加快部署可模拟人类视觉的应用和解决方案。该工具套件基于卷积神经网络(CNN),可在英特尔® 硬件中扩展 CV 工作负载,从而最大限度地提升性能。

英特尔® OpenVINO™ 工具套件分发版集成了英特尔® 深度学习部署工具套件(英特尔® DLDT)。更多信息,请查看在英特尔® OpenVINO™ 工具套件分发版概述页面。

面向 Windows* 10 OS 的英特尔® OpenVINO™ 工具套件分发版:

- 在边缘支持基于CNN的深度学习推理

- 支持跨英特尔®CPU、英特尔® 处理器显卡 (GPU)、英特尔®Movidius™ 神经计算棒、英特尔®神经计算棒2以及采用英特尔®Movidius™ VPU的英特尔®视觉加速器设计等产品的异构执行

- 通过易于使用的计算机视觉函数库和预优化的内核缩短上市时间

- 包括针对计算机视觉标准(包括OpenCV*和OpenCL™)的优化调用

安装包中包含的组件

默认安装以下组件:

| 组件 |

描述 |

| 模型优化器 |

该工具可将在通用框架中训练的模型导入、转换和优化成适用于英特尔工具(尤其是推理引擎)的格式。常见框架包括 Caffe*、TensorFlow*、MXNet*、ONNX* 等等。 |

| 推理引擎 |

这是一款运行深度学习模型的引擎。它包括一组库,可将推理轻松集成至您的应用。 |

| OpenCV* |

针对英特尔® 硬件编译的 OpenCV* 社区版本 |

| 推理引擎示例 |

一组简单的控制台应用,演示了如何在应用中使用英特尔深度学习推理引擎。 |

| 演示 |

一组控制台应用,演示了如何在应用中使用推理引擎处理特定用例 |

| 其他工具 |

一组用于处理模型的工具 |

| 预训练模型文档 |

针对预训练模型的文档详见Open Model Zoo 存储库 |

系统要求

Windows 安装仅支持英特尔® CPU、英特尔® 处理器显卡、英特尔® Movidius™神经计算棒、英特尔® 神经计算棒 2 和采用英特尔® Movidius™ VPU 的英特尔® 视觉加速器设计。FPGA 仅支持 Linux。

硬件

- 第六代至第十代智能英特尔®酷睿™ 处理器

- 英特尔®至强®v5产品家族

- 英特尔®至强®v6产品家族

- 英特尔®Movidius™ 神经计算棒

- 英特尔®神经计算棒2

- 采用英特尔®Movidius™VPU 的英特尔®视觉加速器设计

处理器说明:

- 所有的处理器都不包含处理器显卡。如欲了解有关您的处理器信息,请查看处理器规格。

- 如果您使用的是英特尔至强处理器,则需要使用支持处理器显卡的芯片组。如欲了解有关您的芯片组的信息,请查看芯片组规格。

操作系统

- Microsoft Windows* 10 64 位

软件

安装步骤

安装英特尔® OpenVINO™ 工具套件分发版核心组件

-

如果还未下载英特尔® OpenVINO™ 工具套件分发版,请下载最新版本。默认情况下,该文件w_openvino_toolkitp<version>.exe 的形式保存至 Downloads 目录中。

-

前往Downloads目录中。

-

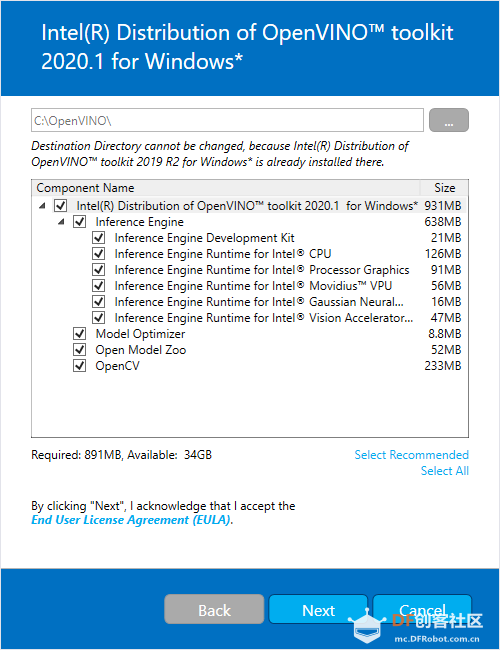

双击w_openvino_toolkitp <version>.exe。将打开一个窗口,让您选择安装目录和组件。默认安装目录为 C:\Program Files (x86)\IntelSWTools\openvino_<version>,为简单起见,还创建了一个最新安装快捷方式:C:\Program Files (x86)\IntelSWTools\openvino。如果您选择其他安装目录,安装程序将为您创建目录:

-

点击Next。

-

您需要回答是否同意收集您的信息。按您自己的意愿选择点击 Next。

-

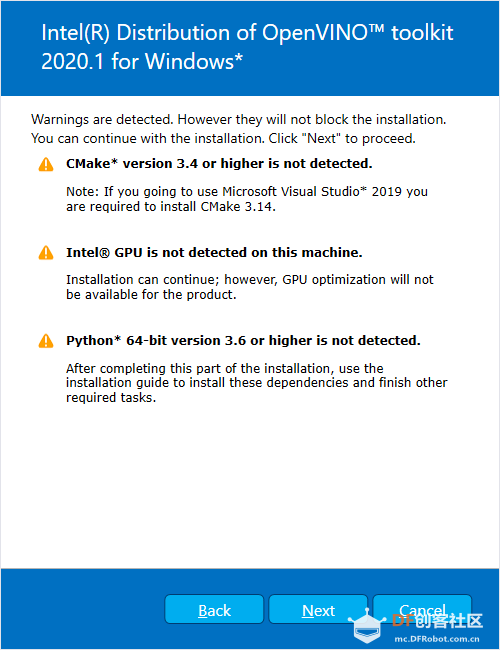

如果缺少外部关联组件,您将会看到一个告警屏幕。请完善您缺少的关联组件。此时无需采取其他措施。安装完英特尔® OpenVINO™ 工具套件分发版核心组件后,安装缺少的关联组件。下方屏幕示例显示您缺少两个关联组件:

-

点击Next。

-

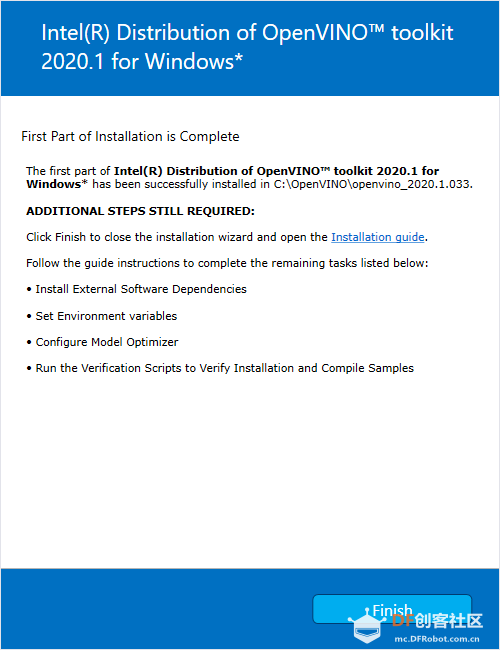

第一部分安装完成后,最终的屏幕会提示您核心组件已安装完成,还需要进行其他几个安装步骤:

-

点击 Finish,关闭安装向导。将打开一个新的浏览器窗口,显示下一节用于设置环境变量的安装指南。您在同一个文档中。如果运行安装时没有事先打开该安装指南,则会打开一个新窗口。

-

如果安装提示您必须安装关联组件,请先按提示操作。如果不缺少关联组件,可以设置环境变量。

设置环境变量

注:如果您将英特尔® OpenVINO™ 工具套件分发版安装在非默认安装目录中,请将 C:\Program Files (x86)\IntelSWTools 替换为您安装软件的目录。

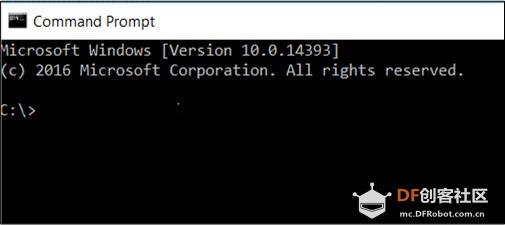

编译和运行 OpenVINO™ 应用之前,必须更新几个环境变量。打开命令提示符,运行 setupvars.bat 批处理文件,以临时设置环境变量:

cd C:\Program Files (x86)\IntelSWTools\openvino\bin\

setupvars.bat

(可选):关闭命令提示符窗口后,OpenVINO 工具套件环境变量将被删除。您可以选择手动永久设置环境变量。

环境变量已设置。继续下一节,配置模型优化器。

配置模型优化器

重要提示:这些步骤必须执行。必须为至少一个框架配置模型优化器。如果本节的步骤没有完成,模型优化器将会运行失败。

注:如果您已安装 Python,但出现错误消息提示 Python 尚未安装,那么您的电脑可能找不到该程序。关于将 Python 添加到您的系统环境变量的说明,请参阅更新Windows 环境变量。

模型优化器是英特尔® OpenVINO™ 工具套件分发版的关键组件。如果不通过模型优化器运行模型,将无法对经过训练的模型进行推理。通过模型优化器运行预训练模型时,输出为网络的中间表示 (IR)。IR 是描述整个模型的一对文件:

- .xml:描述网络拓扑

- .bin:包含权重和偏差二进制数据

推理引擎跨 CPU、GPU 或 VPU 硬件使用通用 API 读取、加载和推理 IR 文件。

模型优化器是基于 Python 的命令行工具 (mo.py),它位于 C:\Program Files(x86)\IntelSWTools\openvino\deployment_tools\model_optimizer。使用该工具将经过通用深度学习框架(如 Caffe 、 TensorFlow 、MXNet 和 ONNX*)训练过的模型转换为优化的 IR 格式,便于推理引擎使用。

本节介绍如何使用脚本同时为所有支持的框架或为单个框架配置模型优化器。如果您不想使用脚本,而想手动配置模型优化器,请登录配置模型优化器页面,参阅“使用手动配置流程”部分。

更多关于模型优化器的信息,请参阅模型优化器开发人员指南。

模型优化器配置步骤

您可以一次性为所有支持的框架配置模型优化器,也可以每次为一个框架配置模型优化器。选择最适合自己的选项即可。如果出现错误消息,请确保您已安装所有关联组件。

重要提示:必须接入互联网,才能成功执行以下步骤。如果只能通过代理服务器接入互联网,请确保已在环境中进行配置。

注:在以下步骤中:

这些步骤使用命令提示符,已确保您看到错误消息。

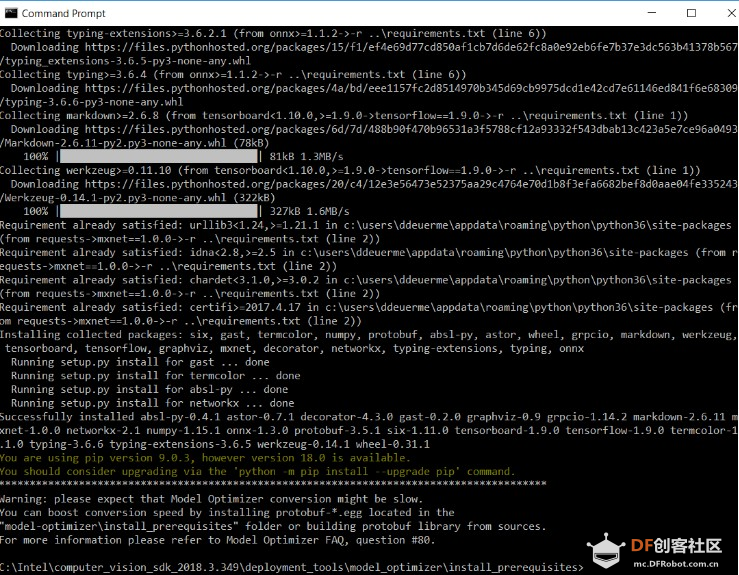

方案 1:同时为所有支持的框架配置模型优化器:

- 打开命令提示符。在 Search Windows 方框中输入 cmd,然后按 Enter。在打开的窗口中输入命令:

- 前往模型优化器先决条件目录。

cd C:\Program Files

(x86)\IntelSWTools\openvino\deployment_tools\model_optimizer\install_prerequisites

- 运行以下批处理文件,为 Caffe、TensorFlow、MXNet、Kaldi 和ONNX* 配置模型优化器:

install\_prerequisites.bat

方案 2:单独为各个框架配置模型优化器:

- 前往模型优化器先决条件目录:

cd C:\Program Files

(x86)\IntelSWTools\openvino\deployment_tools\model_optimizer\install_prerequisites

- 为您即将用于模型优化器的框架运行批处理文件。可以使用多个框架:

- 对于Caffe:

install\_prerequisites\_caffe.bat

- 对于TensorFlow:

install\_prerequisites\_tf.bat

- 对于MXNet:

install\_prerequisites\_mxnet.bat

- 对于ONNX:

install\_prerequisites\_onnx.bat

- 对于Kaldi:

install\_prerequisites\_kaldi.bat

模型优化器面向一个或多个框架进行了配置。如果出现以下类似屏幕信息,表示配置成功:

现在您可以使用两个简短的演示查看英特尔® OpenVINO™ 工具套件分发版的运行结果,并验证安装是否成功。必须使用演示脚本,因为它们要执行其他配置步骤。继续下一节。

如果想使用 GPU 或 VPU,或者更新 Windows 环境变量,请阅读可选步骤部分。如果想使用 GPU 或 VPU,或者更新 Windows\ 环境变量,请阅读可选步骤部分。

使用验证脚本验证安装

重要提示:本节为必选部分。除了确认安装是否成功之外,演示脚本还执行其他步骤,如设置您的计算机,以便使用推理引擎示例。

注:本节中的安装路径假设您使用的是默认安装目录。如果您使用的目录不是C:\Program Files (x86)\IntelSWTools,请将目录更新为安装软件的位置。

如要验证安装并编译两个示例,请在 CPU 上运行随产品一同提供的验证应用:

- 打开命令提示符窗口。

- 前往推理引擎演示目录:

cd C:\Program Files(x86)\IntelSWTools\openvino\deployment\_tools\demo\

- 按照下一节的说明运行验证脚本。

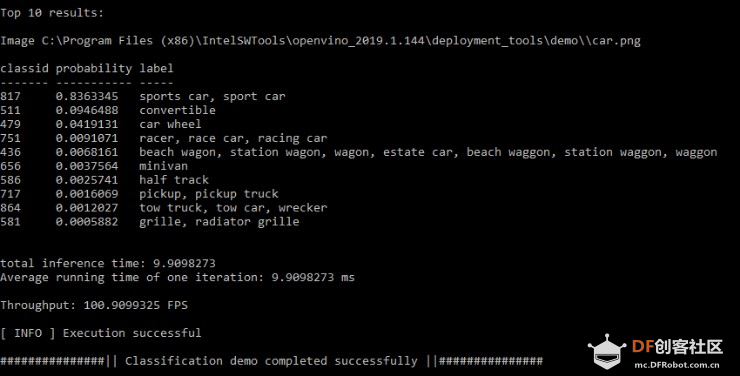

运行图像分类验证脚本

如要运行脚本,请打开demo_squeezenet_download_convert_run.bat 文件:

demo\_squeezenet\_download\_convert\_run.bat

该脚本下载一个 SqueezeNet 模型,使用模型优化器将模型转换为 .bin 和 .xml 中间表示 (IR) 文件。推理引擎必须进行此模型转换,以便将 IR 用作输入,并在英特尔硬件上实现最佳性能。

此验证脚本可以构建图像分类示例同步应用,并使用演示目录中的 car.png 图像运行该应用。有关中间表示的简要介绍,请参阅配置模型优化器。

验证脚本完成后,您获得前 10 个类型的标记和置信度:

演示已完成。让控制台保持打开状态,继续下一节运行推理管道演示。

运行推理管道验证脚本

如要运行脚本,请在控制台打开的前提下,打开demo_security_barrier_camera.bat文件:

demo\_security\_barrier\_camera.bat

该脚本下载三个预训练模型 IR,构建安全障碍摄像头演示应用,并使用下载的模型和 demo 目录中的 car_1.bmp 图像运行该应用,以显示推理管道。该验证脚本可用来进行车辆识别,并通过车辆属性的相互关联,缩小特定属性的范围。

首先,将对象识别为车辆。此识别用作下一模型的输入,以便它识别特定的车辆属性,包括车牌。最后,将识别为车牌的属性作为第三个模型的输入,以便它识别车牌中的特定字符。

演示完成后,将打开两个窗口:

- 一个控制台窗口,显示有关该演示执行的任务信息。

- 一个图像查看器窗口,显示生成的帧,并将检测结果渲染为边界框,与下图类似:

关闭图像查看器窗口,结束演示。

关于验证脚本的更多信息,请查看 C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo 中的 README.txt。

关于 OpenVINO™ 预训练对象检测与对象识别模型的详细信息,请查看OpenVINO™ 工具套件预训练模型概述页面。

本节支持您预先了解英特尔® OpenVINO™ 工具套件分发版的功能。

© 英特尔公司版权所有

前往了解DFRobot行业AI开发者大赛

英特尔® OpenVINO™ 工具套件分发版:点击下载

沪公网安备31011502402448

沪公网安备31011502402448