|

29498| 5

|

[入门] 【保姆级教程】小爱同学+AI!魔改小爱音箱,接入本地... |

|

本帖最后由 RRoy 于 2024-7-9 16:13 编辑 众所周知,小爱和天猫精灵这类语音助手,在现如今显得不那么“聪明”了,现在人人都在聊AI,有办法让我们的语音助手也接入AI,变得聪明一点吗? 答案是肯定的。 GitHub上已经有开发者开源了自己的项目——mi-gpt,介绍语就是:“将小爱音箱接入 ChatGPT 和豆包,改造成你的专属语音助手。”  GitHub仓库地址:https://github.com/idootop/mi-gpt 效果展示: 作者的免责声明: 项目简介(来自官方README) 在这个数字化的世界里,家已不仅仅是一个居住的地方,而是我们数字生活的延伸。 MiGPT 通过将小爱音箱、米家智能设备,与 ChatGPT 的理解能力完美融合,让你的智能家居更懂你。 MiGPT 不仅仅是关于设备自动化,而是关于:打造一个懂你、有温度、与你共同进化的家。 未来,你的每个智能家居设备,从灯泡、插座,到扫地机器人、电视等, 都可以作为一个个独立的智能体 (Agent),更智能、更贴心的响应你的指令。 这些独立的智能体,也可以彼此感知,彼此配合,构成一个更强大的协作网络。 而小爱音箱就像是你的智能家居专属管家,全心全意为你服务,释放智能家居的真正潜力。 功能亮点

考虑到不是人人都是前端 (Node) 开发者,我们这边就用电脑小白也能轻松完成的,使用 Docker 方式来和大家一起手把手搭建这个项目。 准备工作

注意:本项目暂不支持小度音箱、天猫精灵、HomePod 等智能音箱设备,亦无相关适配计划。

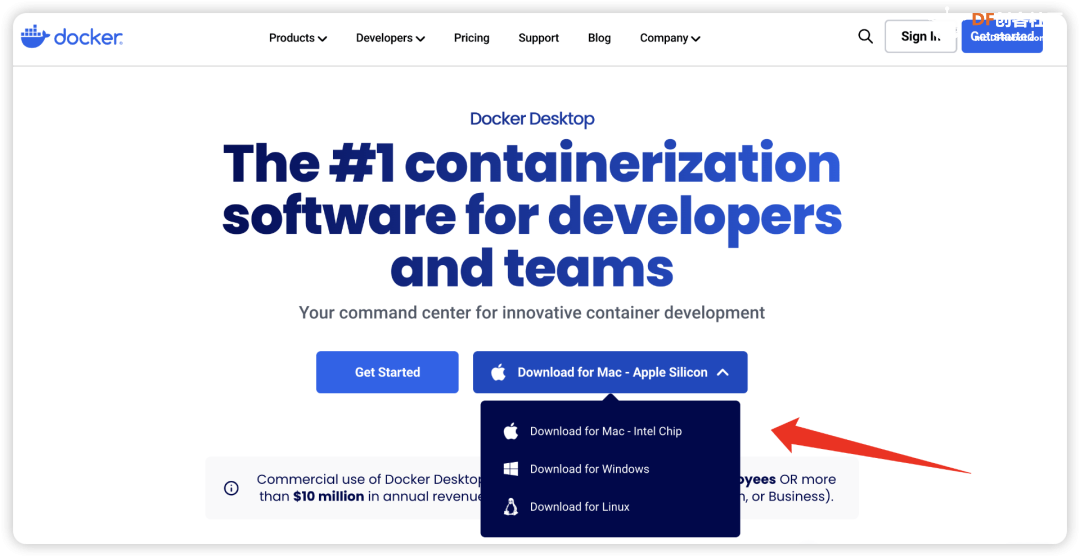

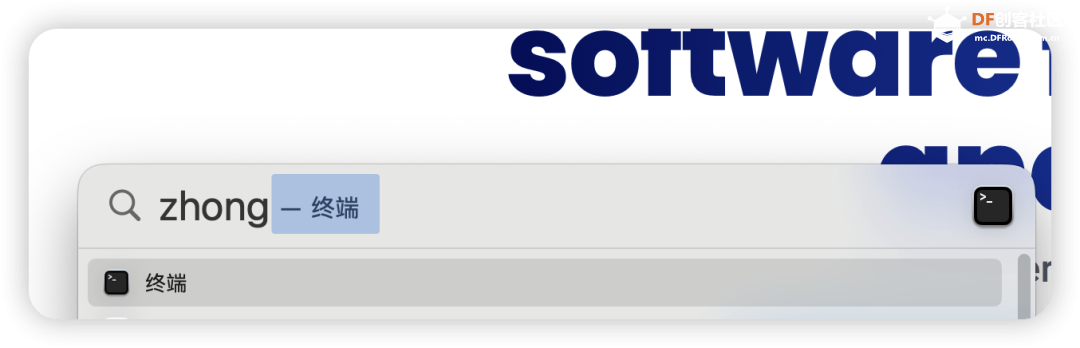

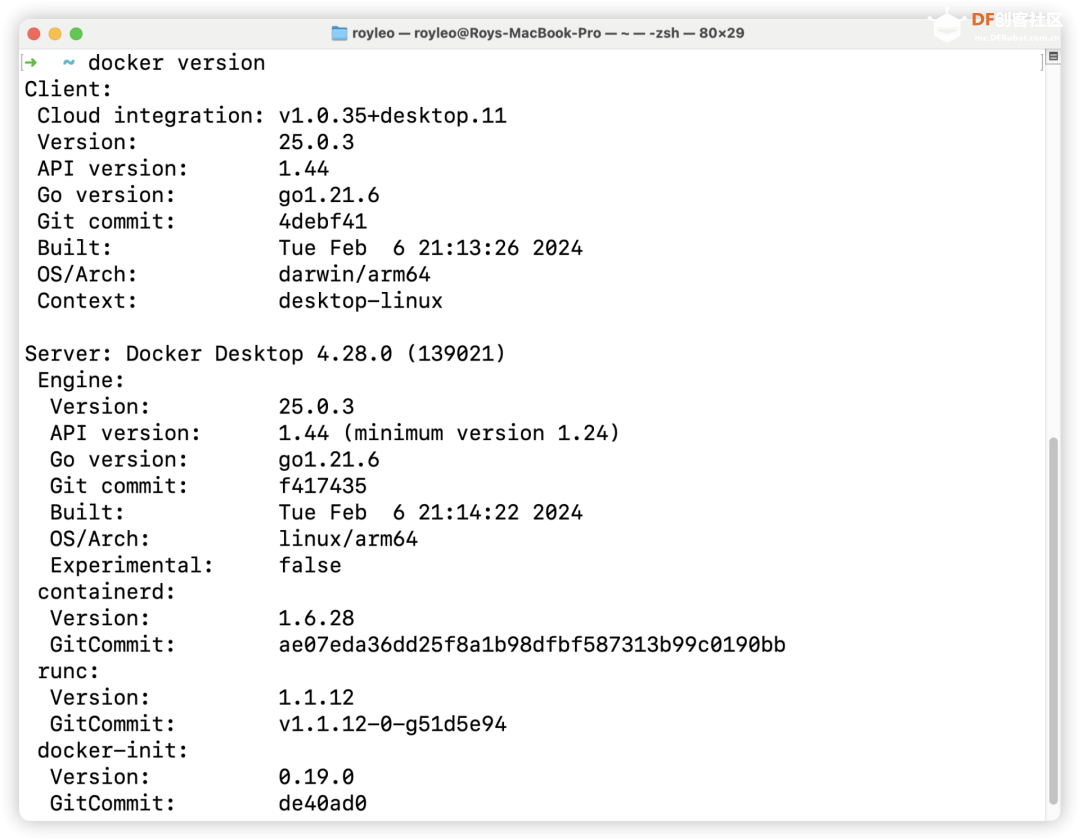

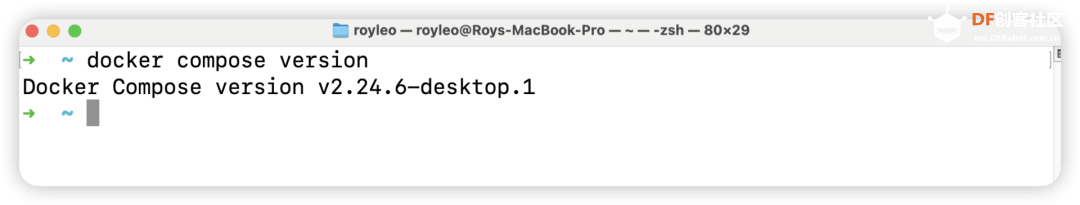

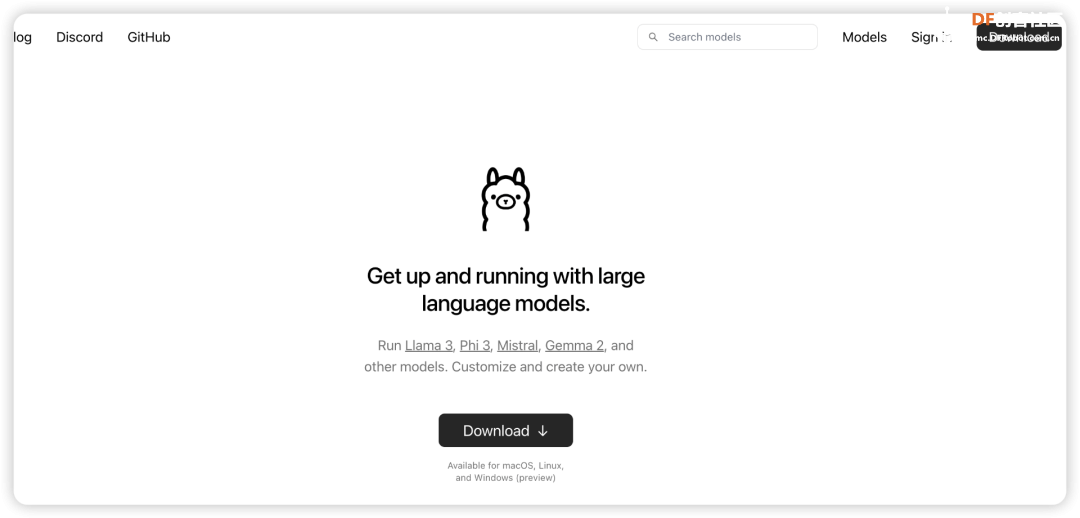

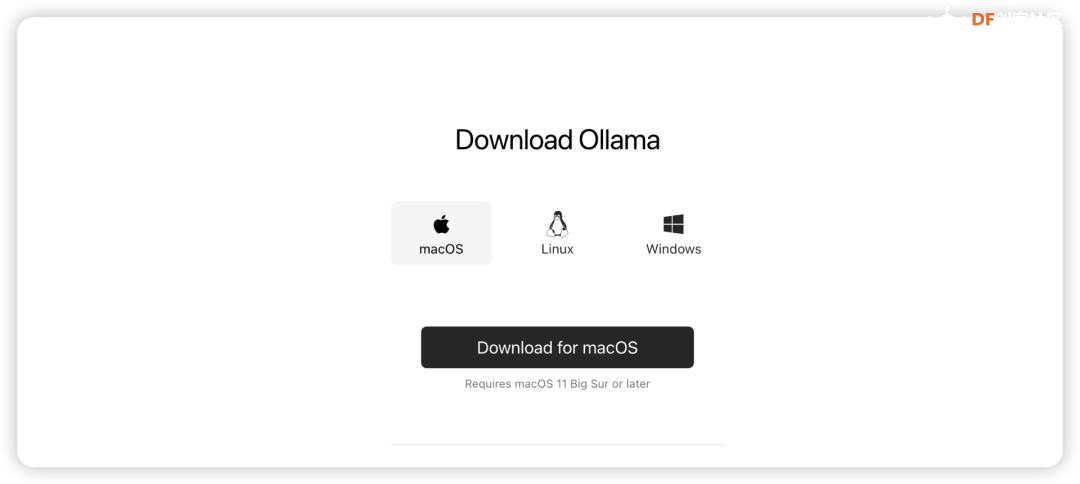

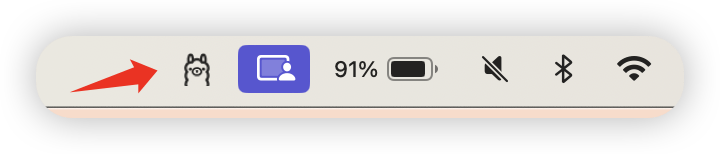

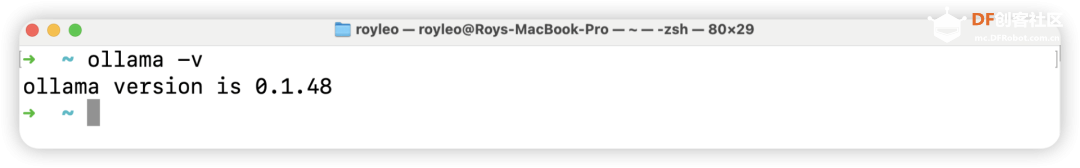

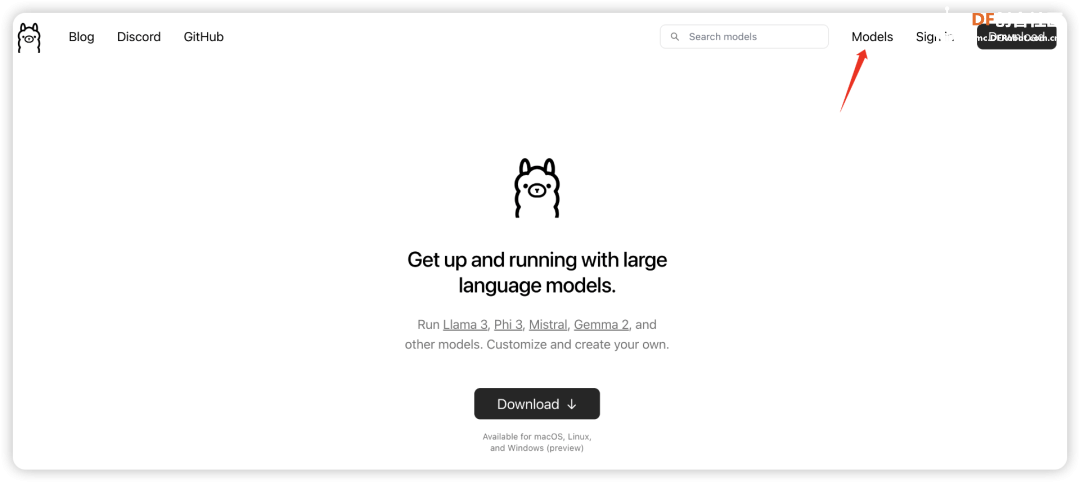

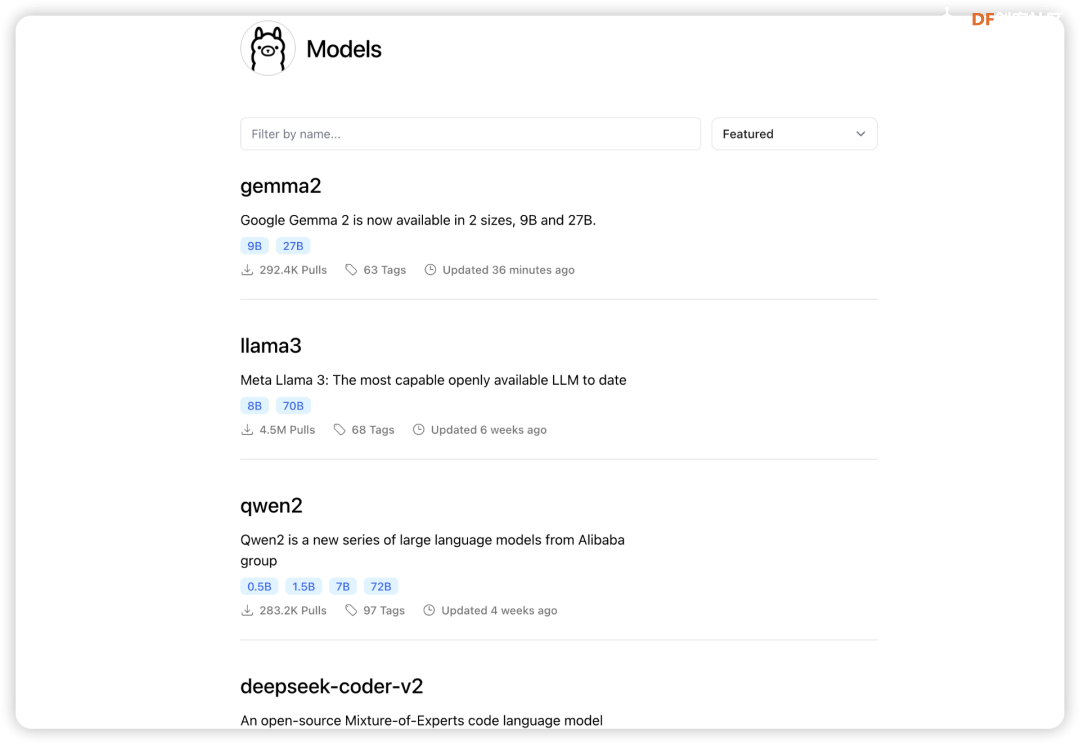

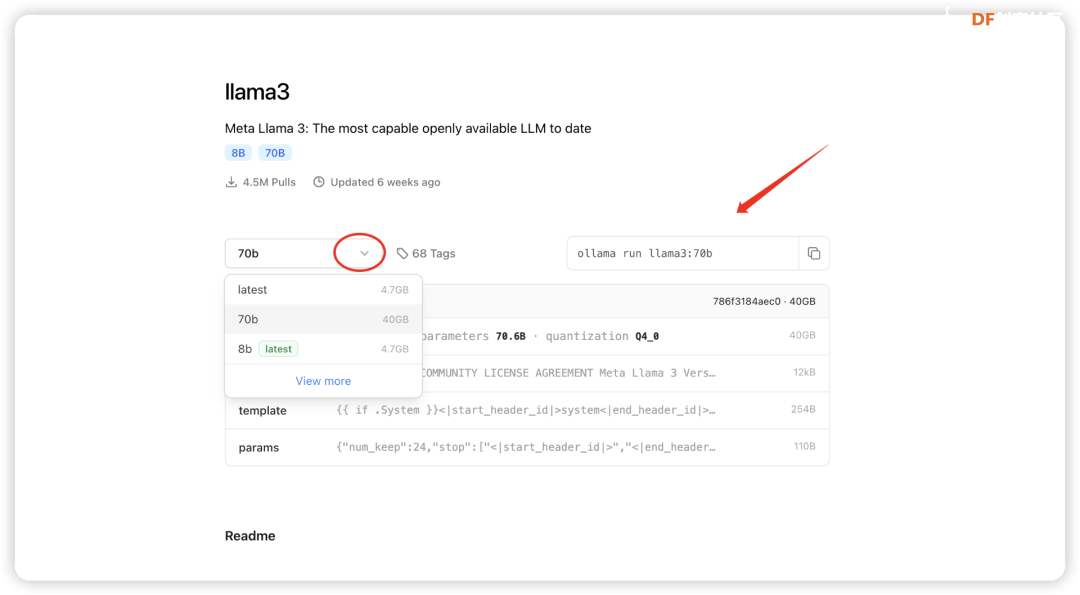

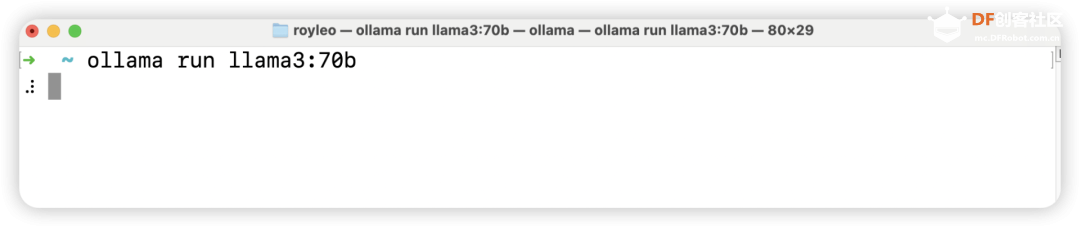

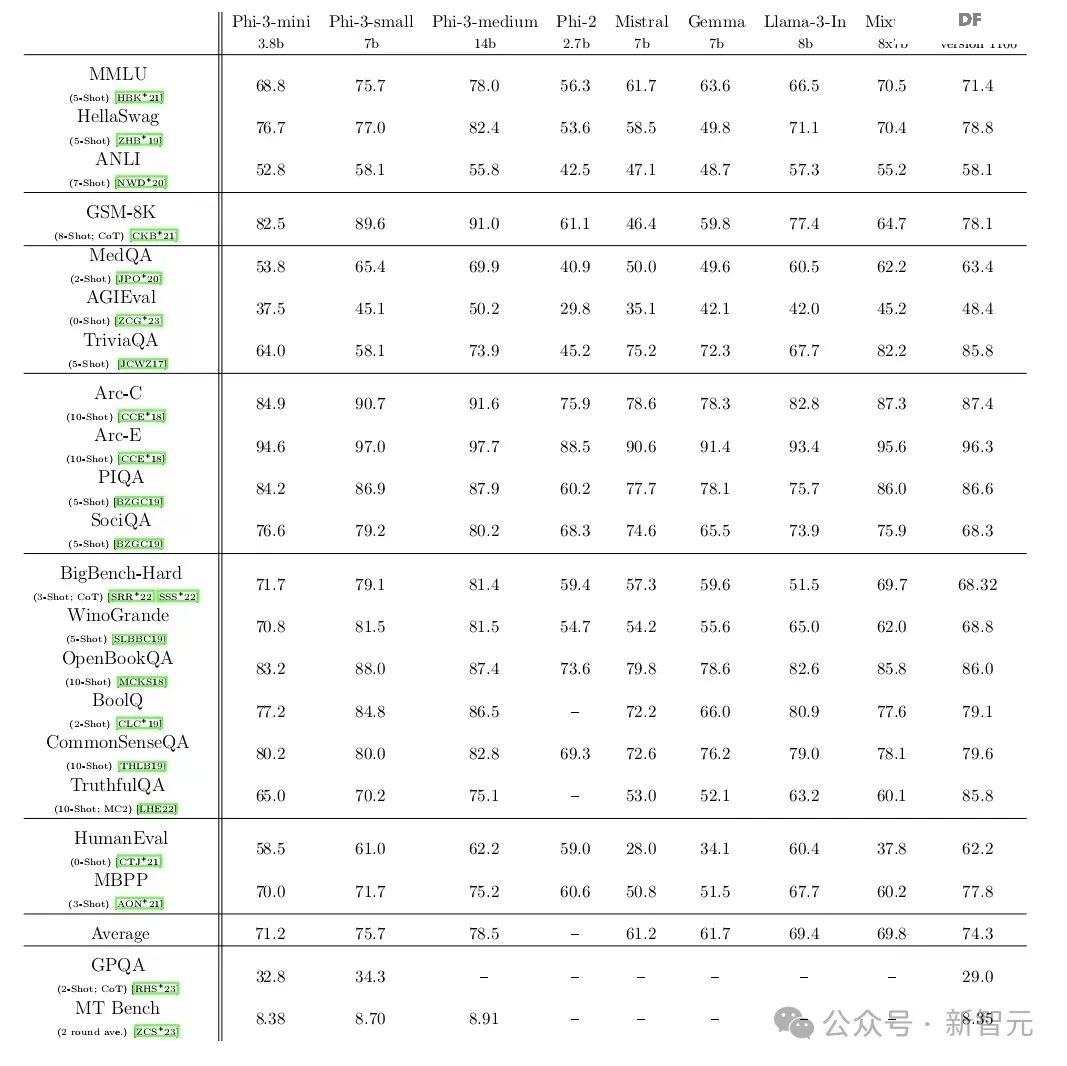

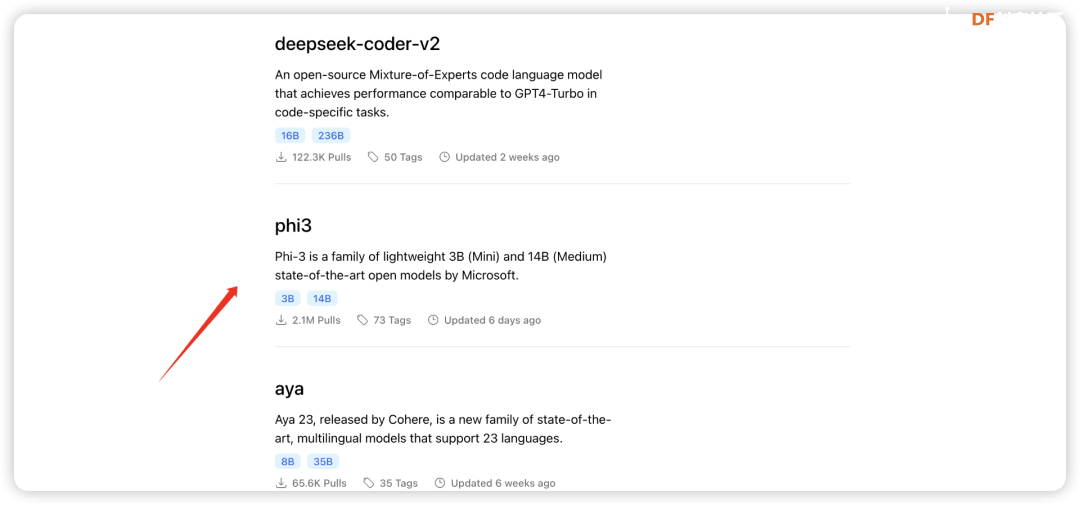

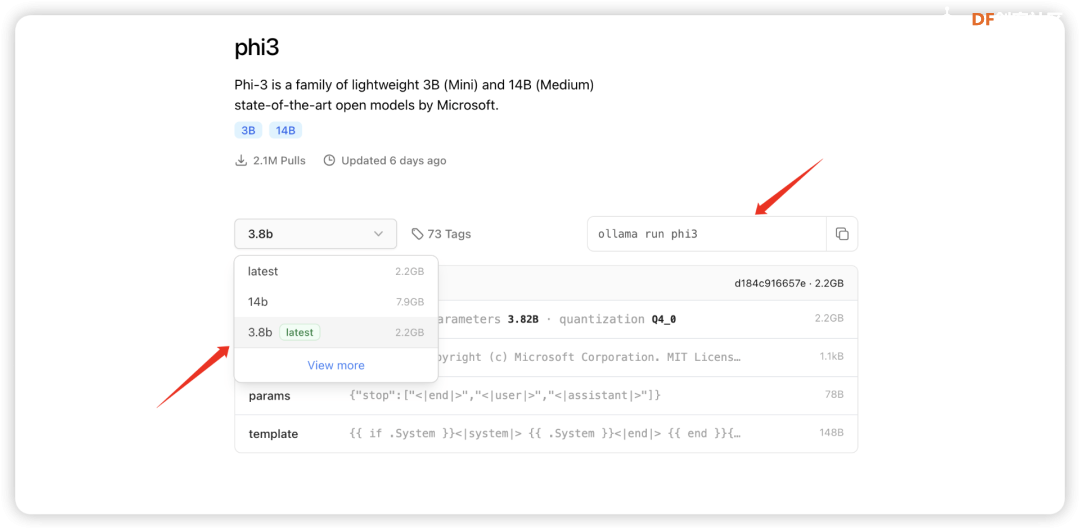

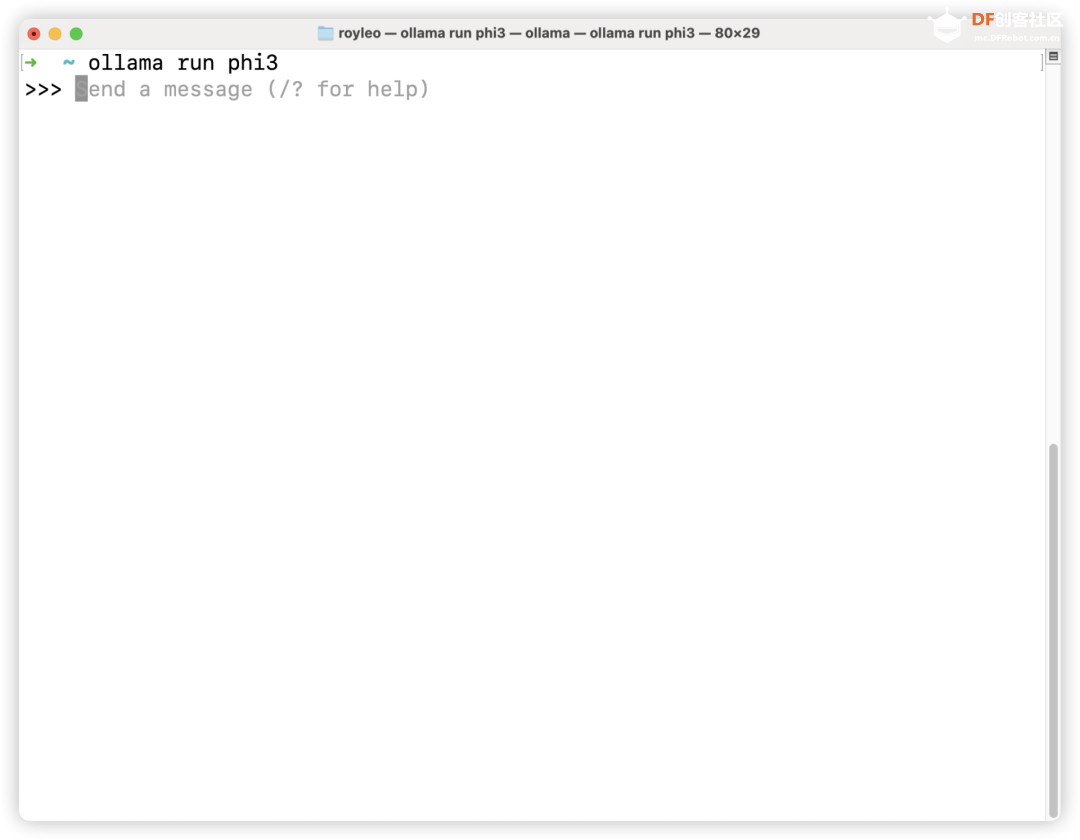

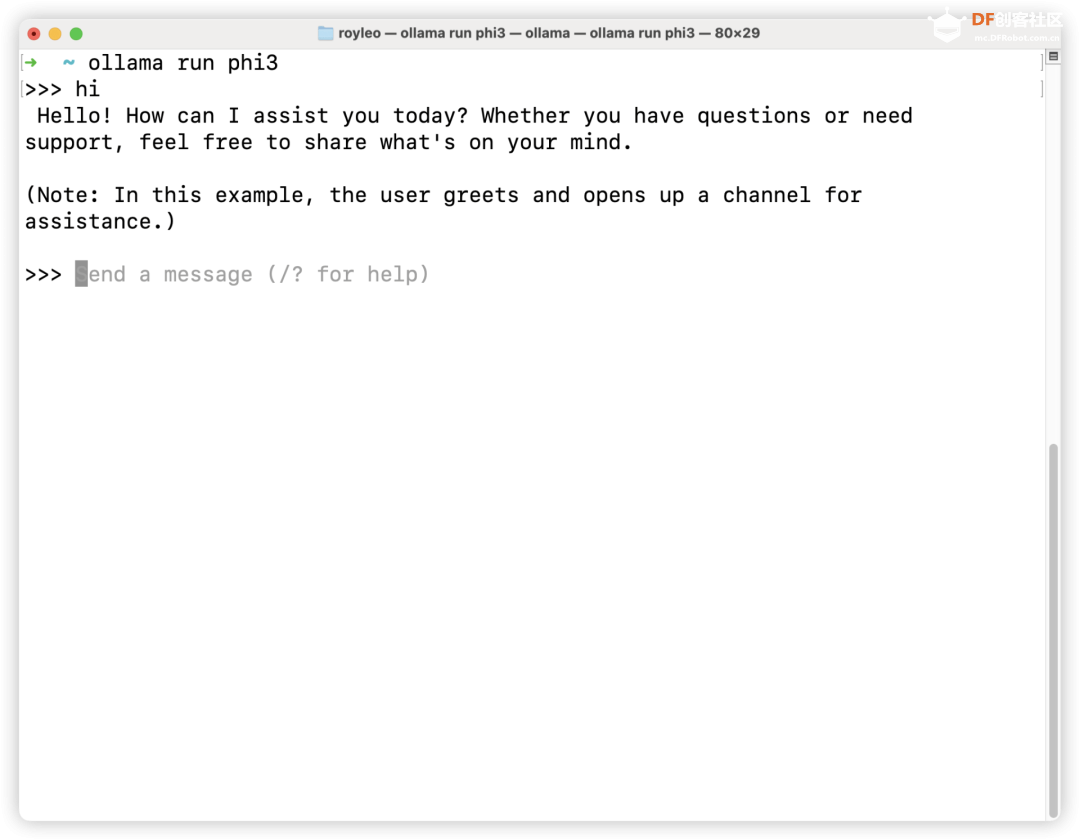

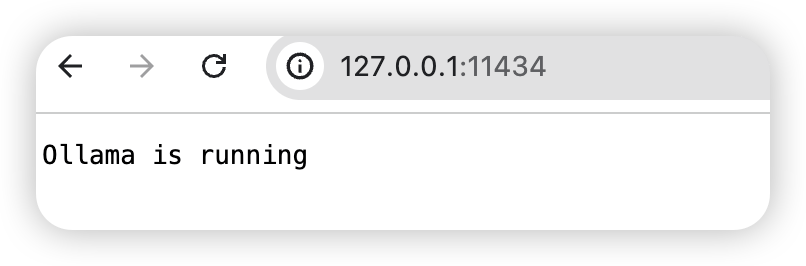

开始安装安装Docker 为了简单,我们可以选择直接去官网下载桌面版本的Docker:https://www.docker.com/products/docker-desktop/  选择对应操作系统下载即可(默认第一个就是适合你系统的) 这边就是和安装软件一样操作即可。 安装完成后,记得启动Docker,  然后Mac上打开“终端”(Windows打开powershell)  输入docker version  如果出现这个信息,说明我们的Docker安装好了。 输入docker compose version,可以查看我们的docker compose 版本号(新版已经默认把docker compose和docker一起安装了,不需要我们再额外安装,很方便)  我们基础环境就搭建好了,后续我们需要借助这个Docker来安装运行我们的mi-gpt! 安装Ollama 接下来我们再来准备一下我们的本地大模型。 先安装Ollama,Ollama你也可以理解成一个和Docker类似的东西,我们的mi-gpt跑在Docker上,我们的本地AI模型是跑在Ollama上(因为直接跑模型的话需要搞一堆复杂的配置,不同系统的配置还不一样,跑ollama上就会简单很多) 我们直接来到官网:https://ollama.com/  点击Download下载,  选择自己的操作系统下载即可。 下载完成之后也一样打开。  就是这个小羊驼。 接着,我们同样然后Mac上打开“终端”(Windows打开powershell) 输入ollama -v  出现版本号证明我们安装好了。 下载本地AI模型 接下来我们就可以来下载本地AI模型了。 细心的小伙伴可能已经发现了,刚ollama的右上角有一个“Models”  点进去就能看到有很多模型可以下载。  比如非常火的llama3、阿里的千问等等。 然后我们看到每个模型的下面有蓝色的8B、70B的字样,这个其实就是参数量(B代表Billion,十亿),一般来说,参数量越大,模型越牛逼。当然也越消耗机器的性能,如果你机器的配置足够高的话,可以下载参数量大一些的模型试试。 比如这个llama3的700亿参数的模型,大小是40G左右,(对比GPT-4 估计拥有约 1.8 万亿个参数)  下载方法是:ollama run llama3:70b Mac上打开“终端”(Windows打开powershell)  它就会自己去下载这个40G的模型了。 当然相信绝大多数人都跑不动这个“大”模型(机器性能不够) 所以最近有一个词火了起来"小语言模型“(SLM,Small Language Model),对应于”大语言模型“(LLM,Large Language Model) 小语言模型的最大优势就是参数小但是性能不弱,对机器的配置要求也会低一些,之后甚至可能可以在手机、树莓派这些设备上很好运行。 4 月底,微软发布了其 Phi-3 SLM 系列,拥有 38 亿到 140 亿个参数(3.8B——14B之间)。 在一系列测试中,微软最小的模型 Phi-3-mini 与 OpenAI 的 GPT-3.5(1750 亿个参数)不相上下,其表现也优于谷歌的 Gemma(70 亿个参数)。  测试通过向模型提出有关数学、哲学、法律等方面的问题,评估了模型对语言的理解能力。 更有趣的是,拥有 70 亿个参数的微软 Phi-3-small 在许多基准测试中的表现都明显优于 GPT-3.5。 资料来自:https://m.ithome.com/html/779732.htm 所以我们就来装一个Phi-3试试吧。   Mac上打开“终端”(Windows打开powershell) 运行: ollama run phi3 第一次ollama会去下载这个模型,下载完之后会出现这个个交互界面:  其实这个时候我们已经可以和模型对话了。 直接输入:hi 它会回复我们:  我们先输入:/bye 退出,一会儿把它接入我们的小爱音箱。 运行mi-gpt Mac上打开“终端”,Windows用户可以安装一个git bash,方法如下: Git Bash 是 Git for Windows 的一部分,提供了一个 Bash 终端环境,让你可以在 Windows 上使用 Git 命令以及许多常见的 Unix/Linux 命令。  下面是安装步骤:

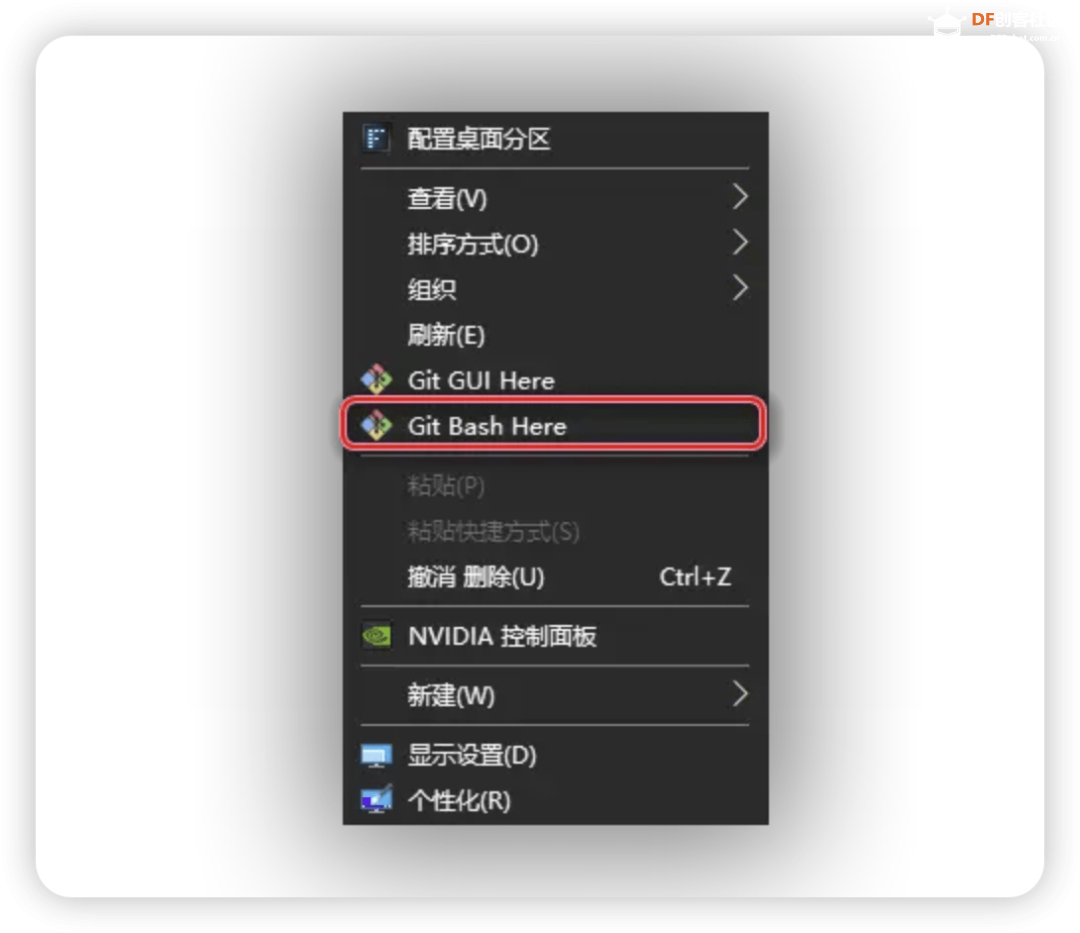

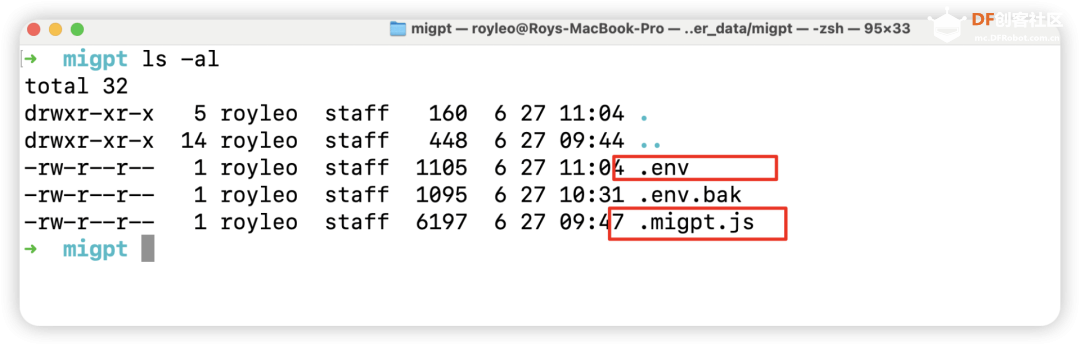

现在,你已经在 Windows 上成功安装了 Git Bash。  任何文件夹中点击右键,选择“Git Bash Here”来打开一个具有该目录路径的 Git Bash 窗口(注意以管理员命令运行) mkdir -p docker_data/migpt cd docker_data/migpt vim .env 其实只要改这三个就行:

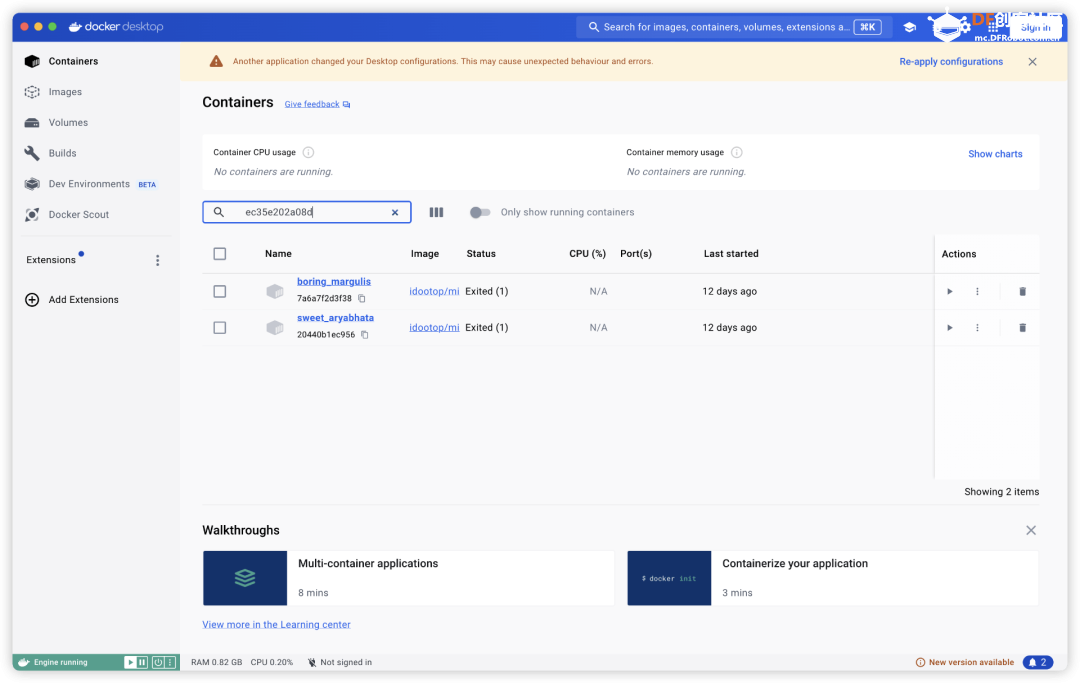

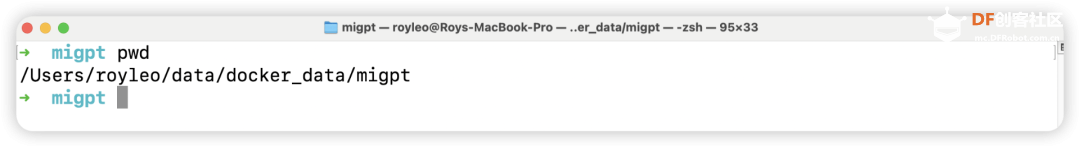

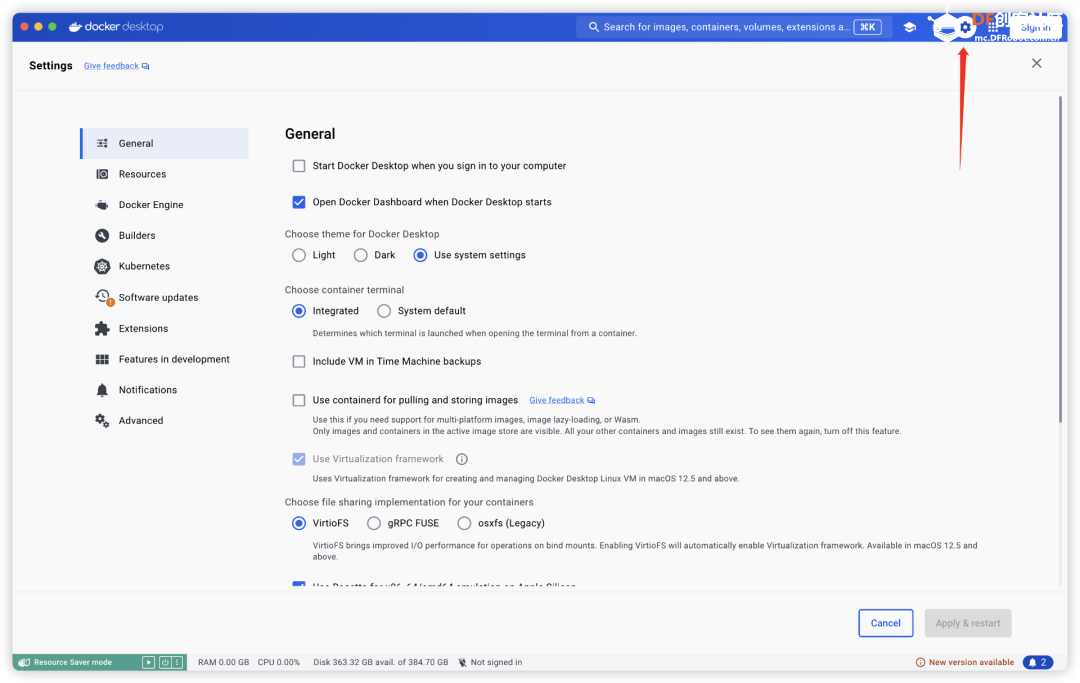

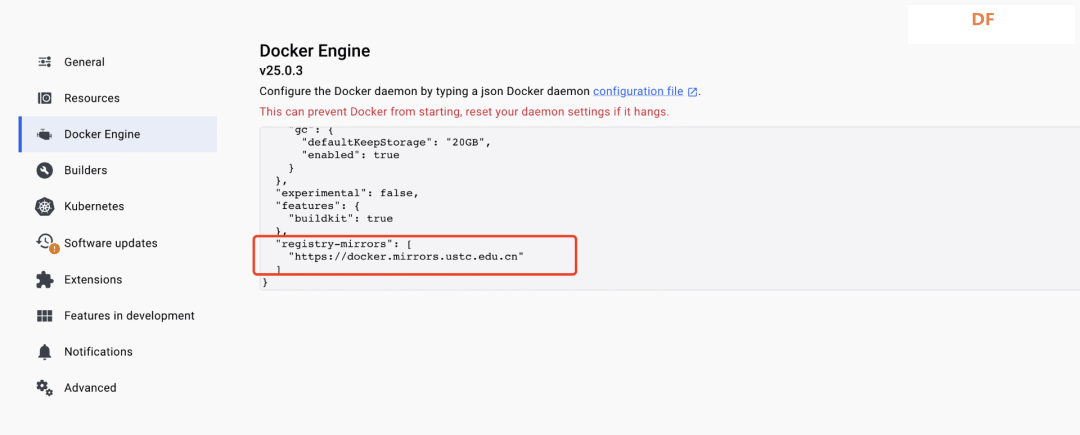

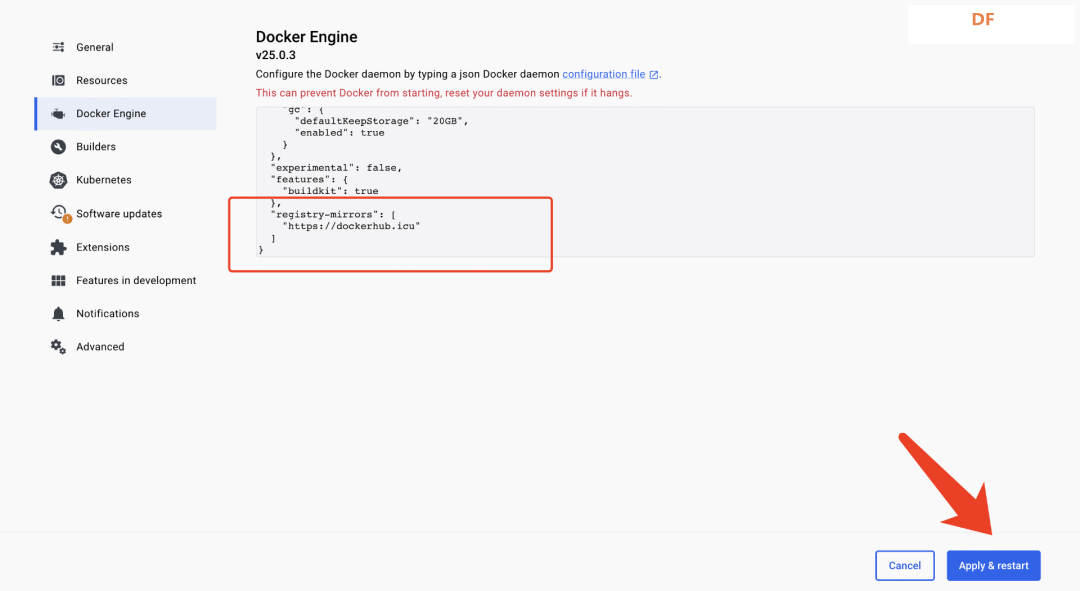

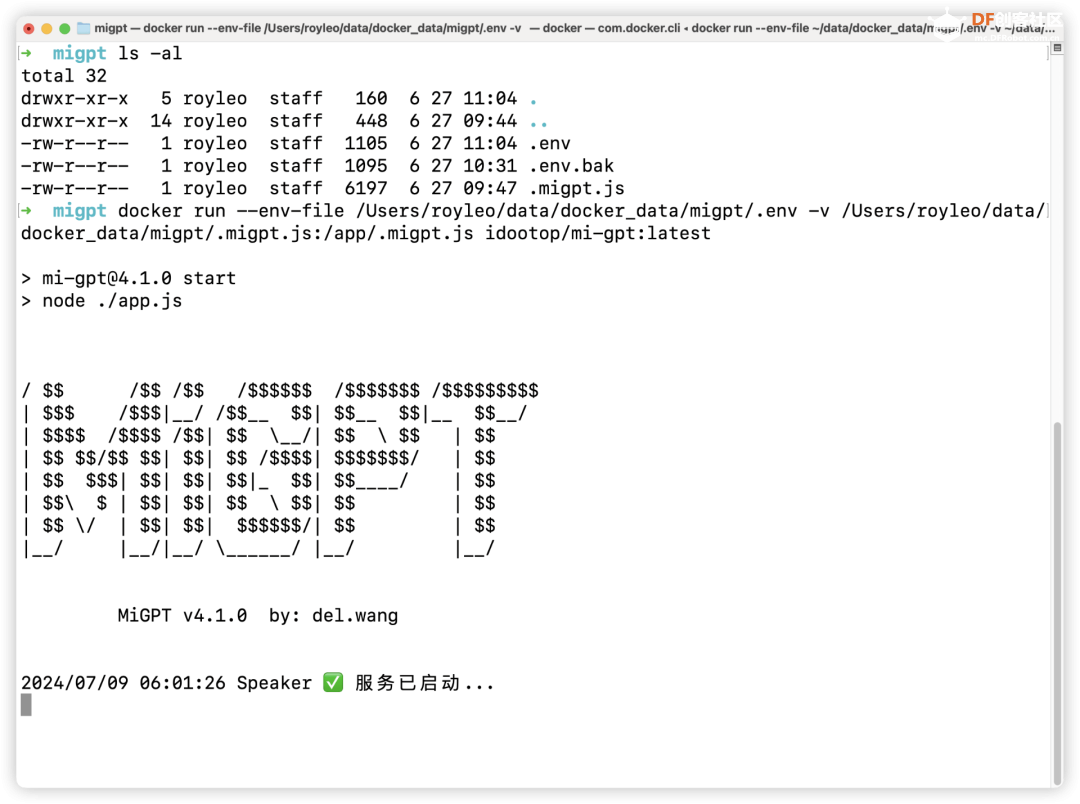

修改完成之后,可以在英文输入法下,按i 修改,完成之后,按一下esc,然后 :wq 保存退出。 vim .migpt.js 修改完成之后,可以在英文输入法下,按i 修改,完成之后,按一下esc,然后 :wq 保存退出。 之后我们就可以运行了, pwd #看看现在的文件夹所在路径  我的路径是/Users/royleo/data/docker_data/migpt  之前的.env和.migpt.js都在这个文件夹下, 更改docker镜像源(如果有代理就开代理) 众所周知的原因,最近国内docker镜像都不好用了, 这边还是要修改一下镜像源,好让我们能正常下载docker镜像:  直接在这边设置下,  可以改成这个https://dockerhub.icu  等docker重新启动之后, 然后我们就运行: 系统会自动去拉取idootop/mi-gpt:latest这个镜像,然后会帮我们自动运行。  当出现这个界面,说明我们启动成功了,可以试试和小爱对话了! 注意这个没有在后台运行,优点是可以实时看到你和小爱的问答情况,方便排查错误。 一旦你关闭这个窗口,就会自动停止mi-gpt。 如果测试完成,可以用这个命令再运行一次,注意加了个-d 意思就是后台运行,这样你就可以关闭窗口了。 当然你还可以加参数让他开机启动docker之后自动运行,加--restart=always就行了 其他的参数可以自己搜索下。 测试效果 启动成功后,你可以通过以下方式来召唤 AI 回答问题:

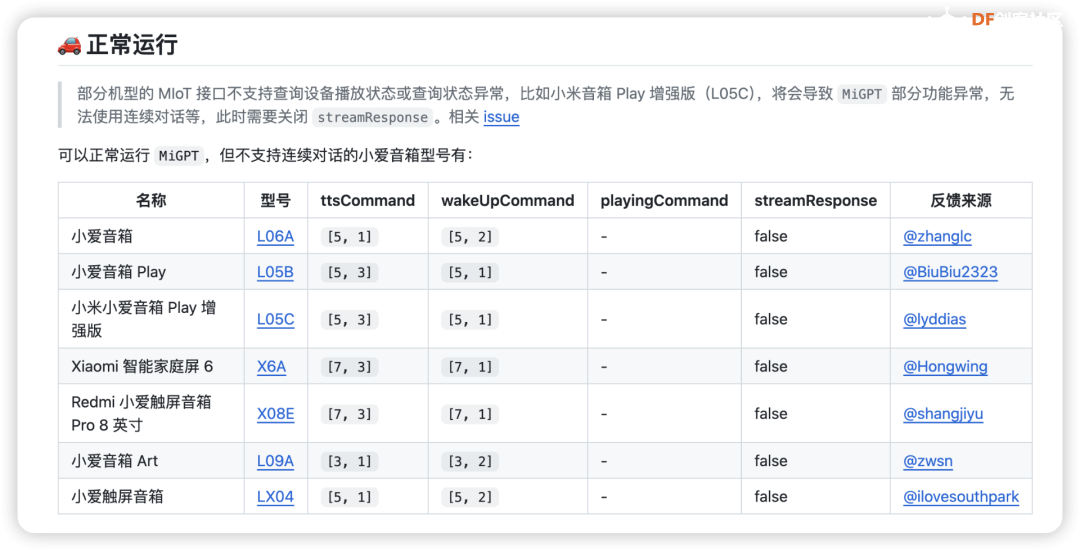

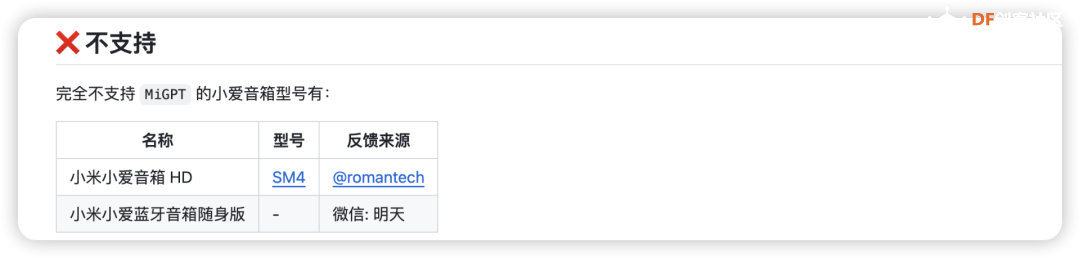

更详细的操作以及后续其他配置的更改,有兴趣的可以先自己看看官方文档,有需求之后我们也会出一期来和大家分享! 高频问题(此部分内容来自官方文档)Q:支持哪些型号的小爱音箱? 大部分型号的小爱音箱都支持,推荐小爱音箱 Pro(完美运行) 查看兼容的小爱音箱型号和配置参数:https://github.com/idootop/mi-gpt/blob/main/docs/compatibility.md Q:除了 OpenAI 还支持哪些模型,如何设置? 理论上兼容 OpenAI SDK的模型都支持,只需修改环境变量即可接入到 MiGPT。比如:通义千问、零一万物、Moonshot、DeepSeek等。以 通义千问为例: OPENAI_BASE_URL=https://dashscope.aliyuncs.com/compatible-mode/v1 OPENAI_MODEL=qwen-turbo OPENAI_API_KEY=通义千问 API_KEY

对于其他不兼容 OpenAI API 的大模型,比如豆包大模型、文心一言等,你也可以通过第三方的 API 聚合工具将其转换为 OpenAI API 兼容的格式。比如: One API和 simple-one-api(推荐:支持 coze,使用更简单),然后修改对应的环境变量值即可完成接入。 关于不同模型的详细申请和配置教程,可以查看这篇文章:MiGPT 接入豆包等大模型教程:https://migptgui.com/docs/apply/ Q:是否支持其他 TTS 服务,如何接入? 支持接入任意 TTS 服务,包括本地部署的 ChatTTS 等。 具体的配置和使用教程,请查看此处:https://github.com/idootop/mi-gpt/blob/main/docs/tts.md Q:AI 回答的速度太慢了,怎么让她变快一点? 默认情况下 MiGPT 的配置参数比较保守,你可以通过酌情修改以下参数加速 AI 回复的速度。 另外你也可以选用 gpt-3.5-turbo 和 gpt-4o 等响应速度较快的模型,来加速 AI 的回复。 Q:什么是唤醒模式(连续对话),如何唤醒 AI? 唤醒模式 类似于小爱技能,可能让你在跟小爱互动的时候,无需每句话都要以“小爱同学”开头唤醒。假设你的唤醒词配置如下: // .migpt.js export default { speaker: { // 当消息以下面的关键词开头时,会调用 AI 来回复消息 callAIKeywords: ["请", "你", "傻妞"], // 当消息以下面的关键词开头时,会进入 AI 唤醒状态 wakeUpKeywords: ["打开", "进入", "召唤"], // ... }, }; 唤醒 AI 分为以下 2 种类型,关于唤醒模式的更多细节,请查看https://github.com/idootop/mi-gpt/issues/28。

Q:连续对话模式下,和小爱音箱说话没有反应是怎么回事? 需要注意提问的时机,在小爱正在回答问题或者她没在听你说话(唤醒)的时候,你跟她说话是接收不到的。

还有一种情况是:你的指令触发了小爱音箱内部的一些操作,比如播放/暂停,讲个笑话之类, 这种语音指令并不会被记录到小爱的历史消息中,故在外部无法接收到和正常处理你的此类语音指令。 Q:有时回答太长说个没完没了,如何打断小爱的回复? 只需重新唤醒小爱同学,让她闭嘴即可,或者重新问她一个问题。比如:“小爱同学,请你闭嘴。” 启动失败类问题Q:提示“70016:登录验证失败”,无法正常启动 账号密码不正确。注意小米 ID 并非手机号或邮箱,请在「个人信息」-「小米 ID」:https://account.xiaomi.com/fe/service/account/profile查看,相关 issue:https://github.com/idootop/mi-gpt/issues/10。 Q:提示触发小米账号异地登录保护机制,等待 1 个小时后仍然无法正常启动 这是因为小米账号触发了异地登录保护机制,需要先通过安全验证。打开小米官网登录你的小米账号,手动通过安全验证,通常等待 1-24 小时左右就可以正常登录了。

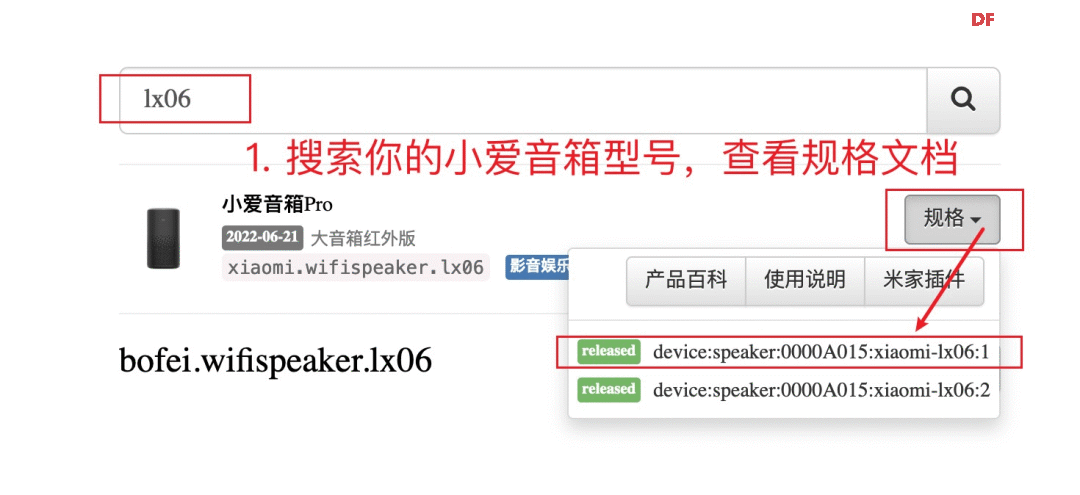

在一些极端情况下,可能会因为你的服务器 IP 太脏,而导致一直无法正常访问小米账号登录链接。此时你可以尝试可以在本地运行 MiGPT,登录成功后把 .mi.json 文件导出,然后挂载到服务器对应容器的 /app/.mi.json 路径下即可解决此问题。相关 issuehttps://github.com/idootop/mi-gpt/issues/22#issuecomment-2148956802 Q:提示“找不到设备:xxx”,初始化 Mi Services 失败 填写的设备 did 不存在,请检查设备名称是否和米家中的一致。相关 issue: https://github.com/idootop/mi-gpt/issues/30。 查看小爱音箱设备名称:打开米家 - 进入小爱音箱主页 - 点击右上角更多 - 设备名称 常见错误设备名称示例,建议直接复制米家中的设备名称: 某些情况下 Mina 和 MIoT 中的设备名称可能不一致,此时需要填写设备 did。 先在 .migpt.js 配置文件中打开调试,重启 docker 然后找到你的小爱音箱的 miotDID 填入 .migpt.js 即可。 注意:Mina 获取不到共享设备,如果你的小爱音箱是共享设备,是无法正常启动本项目的。相关 issue: https://github.com/idootop/mi-gpt/issues/86 Q:提示“ERR_MODULE_NOT_FOUND”,无法正常启动 配置文件 .migpt.js 不存在或有错误。检查 docker 下是否存在 /app/.migpt.js 文件以及内容是否正确,相关 issue: https://github.com/idootop/mi-gpt/issues/45。 注意:在 Windows 终端(比如:PowerShell、cmd)下启动 docker 时,无法使用 $(pwd) 获取当前工作目录绝对路径,需要填写 .env 和 .migpt.js 文件的绝对路径。示例: 播放异常类问题Q:小爱音箱收到消息后,没有调用 AI 进行回复 MiGPT 收到消息默认不会调用 AI 进行回复,只会回复以唤醒词开头的消息,比如:“请问 xxx”、“你 xxx” 等,你也可以自定义唤醒词(callAIKeywords)列表。 注意:你需要先召唤小爱同学,而非直接对小爱音箱说:“请你 xxx”,这样是无效的,因为还没有唤醒小爱同学,你说的话她接收不到。 // 错误示范 请问地球为什么是圆的? // 正确示范 小爱同学,请问地球为什么是圆的? Q:小爱音箱没有播放 AI 的回答,但控制台有打印 AI 的回复 不同型号的小爱音箱 TTS 指令不同: issues#5: https://github.com/idootop/mi-gpt/issues/5#issuecomment-2122881495 请到https://home.miot-spec.com查询具体指令,并修改配置文件中的 ttsCommand 参数。 查看教程:   Q:小爱音箱没有读完整个句子,总是戛然而止 部分型号的小爱音箱不支持通过 Mina 获取设备播放状态,只能通过 MiOT 指令查询。 请到 https://home.miot-spec.com 查询具体指令,并修改配置文件中的 playingCommand 参数。 查看教程:  如果修改参数后问题仍然存在,说明你的设备不支持通过开放接口查询播放状态(比如:小米音箱 Play 增强版),此问题无解。建议更换其他型号的小爱音箱(推荐小爱音箱 Pro),相关 issue:https://github.com/idootop/mi-gpt/issues/14。 或者你也可以关闭配置文件中的流式响应(streamResponse)选项,确保小爱能够回复完整的句子。不过需要注意的是,关闭流式响应后,唤醒模式等功能将会失效。 Q:进入唤醒模式时小爱莫名开始播放歌曲 有时小爱同学会把你进入唤醒模式的唤醒语,当成是歌曲名称来播放,比如“唤醒”等,此时可以尝试更换其他唤醒词,比如“打开”等。 网络异常类问题Q:提示“LLM 响应异常 Connection error”,AI 回复失败 网络异常。OpenAI 的服务在国内需要配代理才能访问,相关 issue: https://github.com/idootop/mi-gpt/issues/36。 对于国内环境无法访问 OpenAI 服务的情况,有以下几种处理方法:

Q:Docker 镜像拉取失败 网络异常。近期国内代理普遍不稳定,可以设置 Docker Hub 国内镜像。 相关教程: https://github.com/idootop/mi-gpt/issues/31#issuecomment-2153741281 大模型类问题Q:我想在本地部署大模型,如何在本项目中使用? 你可以使用 Ollama、LM Studio、mistral.rs等项目在本地部署大模型,它们都开箱自带兼容 OpenAI 的 API 服务,修改对应的环境变量值即可完成接入。 Q:提示“LLM 响应异常 404 The model gpt-4o does not exist” 当前 OpenAI 账号没有使用 gpt-4 系列模型的权限,请切换到 gpt-3 系列模型,比如:gpt-3.5-turbo。相关 issue:https://github.com/idootop/mi-gpt/issues/30#issuecomment-2154656498 Q:提示“LLM 响应异常,401 Invalid Authentication” 无效的 OpenAI_API_KEY。请检查 OpenAI_API_KEY 是否能正常使用,以及对应环境变量是否生效。相关 issue:https://github.com/idootop/mi-gpt/issues/59 Q:提示“LLM 响应异常,403 PermissionDeniedError” 代理 IP 被 Cloudflare 风控了,试试看切换代理节点。或者把环境变量里的 HTTP_PROXY 设置成空字符串 HTTP_PROXY='' 关闭代理(仅适用于国产大模型)。相关 issue:https://github.com/idootop/mi-gpt/issues/33 Q:提示“LLM 响应异常,404 Not Found” 模型路径不存在或者代理 IP 被风控。请检查 OPENAI_BASEURL 等环境变量是否配置正确,或切换代理节点后重试。相关 issue:https://github.com/idootop/mi-gpt/issues/43 Q:是否支持 Azure OpenAI,如何配置? 如果你想使用 Azure OpenAI Service:https://azure.microsoft.com/en-us/products/ai-services/openai-service,可通过配置以下环境变量开启: OPENAI_API_VERSION=2024-04-01-preview AZURE_OPENAI_API_KEY=你的密钥 AZURE_OPENAI_ENDPOINT=https://你的资源名.openai.azure.com AZURE_OPENAI_DEPLOYMENT=你的模型部署名,比如:gpt-35-turbo-instruct 注意:Azure OpenAI Studio 部署页面显示的模型版本号,可能并非实际的 OPENAI_API_VERSION 值。请打开模型 Play Ground 页面,选择你想用的部署(模型),然后点击示例代码,查看里面的 api_version 并替换上面的 OPENAI_API_VERSION 的值。 其他问题Q:如何打开调试开关? 调试模式下可以输出更为详细的错误日志,方便分析和定位错误来源。你可以按照下面的配置方式开启 debug 模式: Q:怎么在群晖上使用这个项目?在群晖 docker 控制面板新建项目,按如下示例填写配置。 参考教程:https://github.com/idootop/mi-gpt/issues/41 注意:其中的 env_file 和 volumes 路径,请根据自己的配置文件实际路径来填写。 Q:“小爱同学”唤醒词能否换成其他的,比如“豆包”等 不可以,小爱音箱的唤醒词(小爱同学,xxx)是小爱音箱固件里写死的,外部无法自定义。 要想修改只能刷机替换自己训练的语音识别模型。 相关讨论:https://github.com/idootop/mi-gpt/issues/84#issuecomment-2164826933) Q:如何关闭 AI 开始和结束回复的提示语? 在配置文件中,将对应提示语属性设置成空数组即可,比如: Q:是否支持同时使用多个小米音箱设备/账号? 目前 MiGPT 只支持单实例运行。但是你可以通过创建多个不同设备/账号配置的 docker 容器,来实现对多设备/账号的支持,相关 issue:https://github.com/idootop/mi-gpt/issues/51。 Q:MiGPT 是否需要和小爱音箱在同一局域网下运行? 不需要。MiGPT 底层是调用的 MIoT 云端接口,可在任意设备或服务器上运行,无需和小爱音箱在同一局域网下。 Q:原来的小爱同学会在 AI 回答之前抢话? 与本项目的实现原理有关。本项目通过轮询小米接口获取最新的对话信息,当检测到小爱在回复的时候会通过播放静音音频等方式快速 mute 掉小爱原来的回复。但是从小爱开始回复,到上报状态给小米服务云端,再到本项目通过小米云端接口轮训到这个状态变更,中间会有大约 1 -2 秒的延迟时间,无解。 这个问题,理论上需要通过刷机才能完美解决,可以参考下面的相关讨论:

试试这样说:小爱同学,你是 xxx,你 xxx,比如: 小爱同学,你是蔡徐坤。你是一名歌手,喜欢唱跳 rap。 或者如果你想更新自己的人物设定,可以这样说:小爱同学,我是 xxx,我 xxx Q:怎样使用豆包的音色 本项目暂不对外提供豆包 TTS 服务,但是你可以使用与豆包同款的火山 TTS 引擎。 具体的配置和使用教程,请查看此处:[使用第三方 TTS]:https://github.com/idootop/mi-gpt/blob/main/docs/tts.md Q:怎样控制米家设备? 这是一个 todo 功能,尚未开始开发。后面有时间的话,我会继续添加智能家居 Agents 和插件系统(比如联网搜索,自定义语音指令)等功能,保持关注。 Q:我还有其他问题 请先在 FAQ 和 issue 列表搜索是否有人遇到与你类似的问题并已解答。如果确认是新的问题,请在此处提交 [issue]:https://github.com/idootop/mi-gpt/issues 反馈,并提供详细的问题描述和相关错误截图。 项目GitHub地址:https://github.com/idootop/mi-gpt 此文首发于:DF创客社区 转载请注明来源信息 |

沪公网安备31011502402448

沪公网安备31011502402448© 2013-2026 Comsenz Inc. Powered by Discuz! X3.4 Licensed