本帖最后由 云天 于 2025-9-20 08:30 编辑

【项目背景】

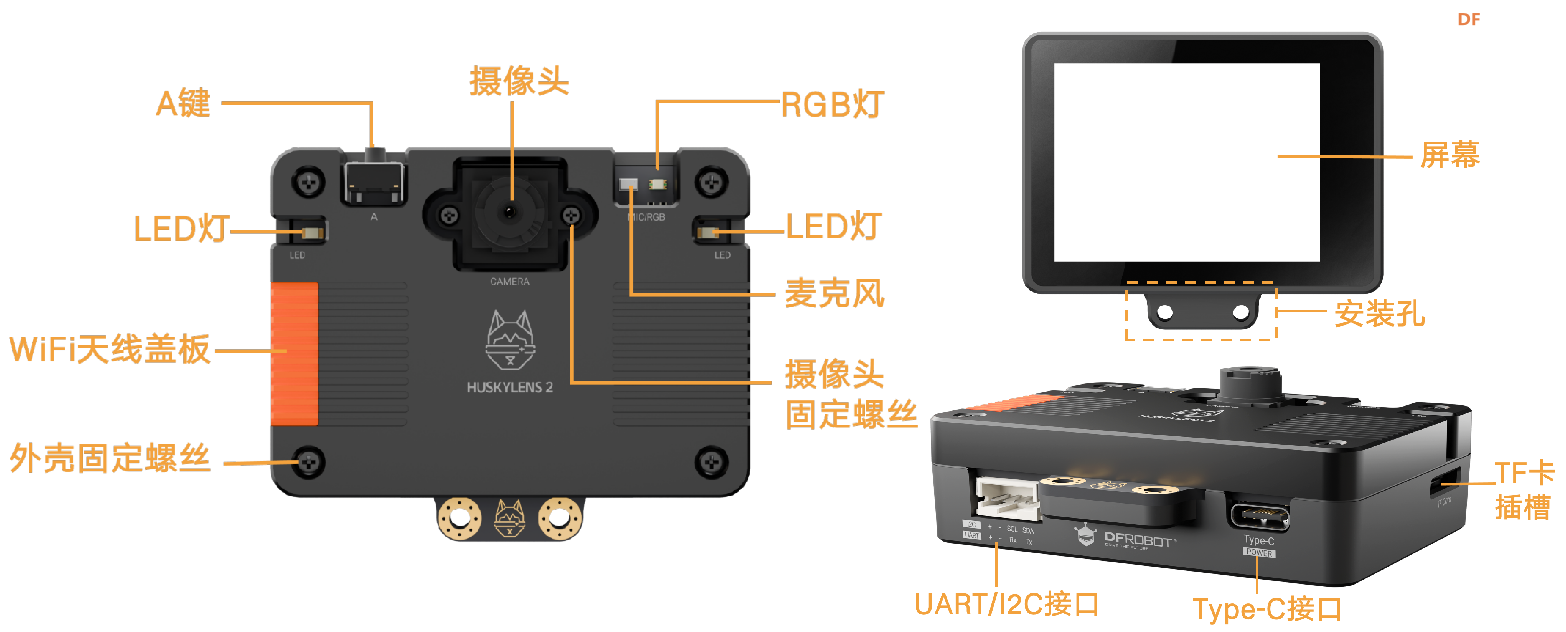

2025年9月,DFRobot正式发布HuskyLens 2 AI视觉传感器,在教育部《中小学人工智能通识教育指南》落地实施的第一学期,为“AI进课堂”提供了与课程标准同步的硬件载体。与第一代相比,HuskyLens 2在算力、存储、交互和算法层面完成全面革新:

- 6 TOPS高算力 + 1 GB内存 + 8 GB存储,可在本地流畅运行YOLOv8-Mobile、Pose-Net等复杂模型,将姿态识别帧率提升至30 fps,延迟<50 ms;

- 2.4英寸IPS电容触摸屏,支持“所见即所得”的即时标定,学生无需PC即可完成模型学习、参数调节与结果显示;

- 全金属机身与主动散热,保证全天候教学场景下的稳定性;

- 出厂内置“人体姿态识别”算法,直接输出14个关键点三维坐标,省去训练、量化、部署环节,真正实现“开机即用”。

在此背景下,本项目率先将HuskyLens 2引入中小学AI通识课堂,通过“人体即遥控器”的四驱车任务,把抽象的坐标系、条件判断、电机差速控制等知识点转化为可观察、可体验、可迭代的项目式学习活动。学生仅需图形化拖拽积木编程(AI感知→逻辑判断→运动控制),就能在10分钟内完成“手势→小车动作”的完整闭环,大幅降低AI入门门槛,

【项目设计】

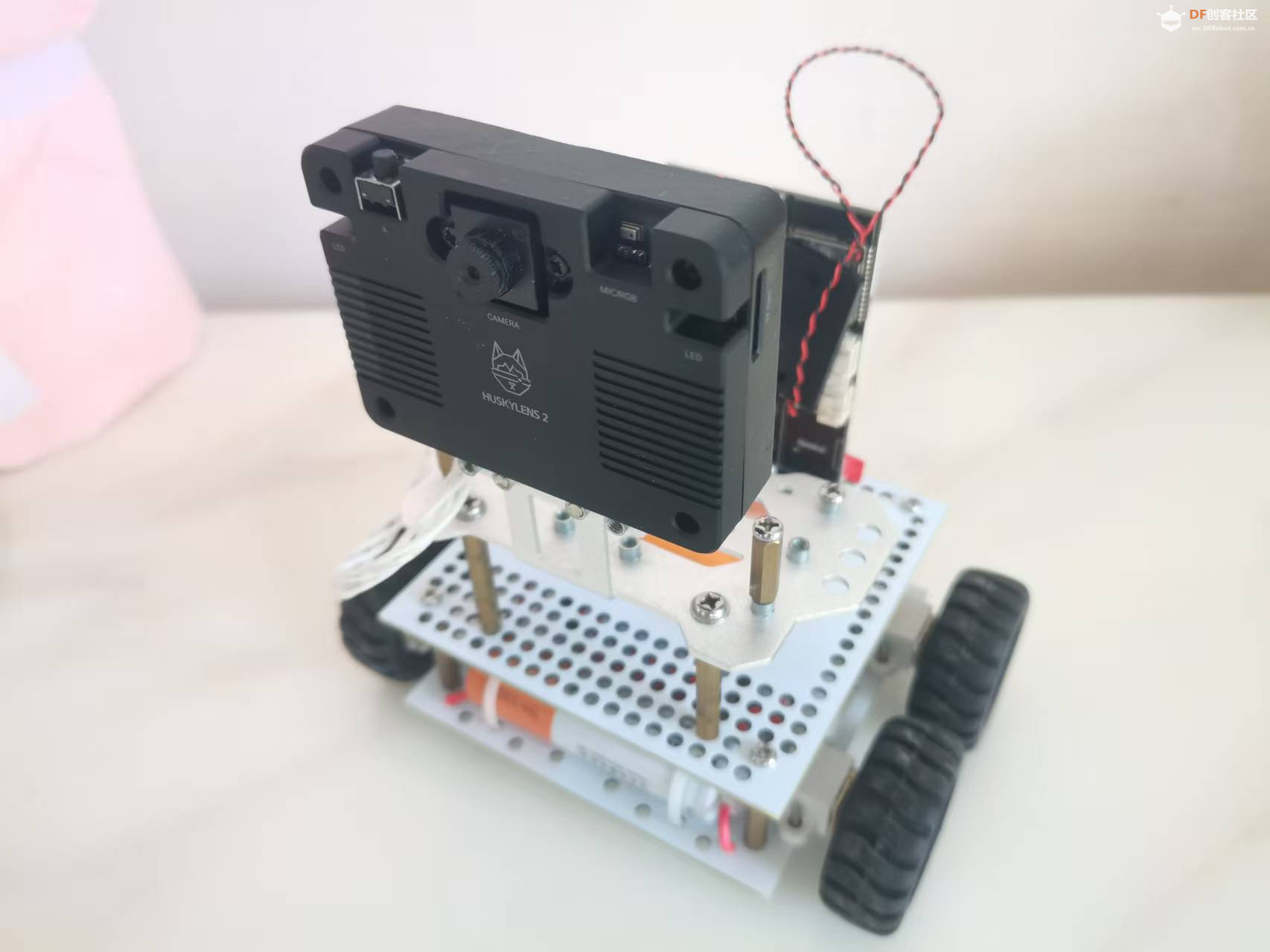

用于控制行空板K10主控板,结合Huskylens 2 AI摄像头实现人体姿态识别来控制四驱车运动。基于人体姿态识别的AI四驱车控制程序,通过识别人体关键点(如眼睛、肩膀、手腕)的相对位置来判断动作,并控制小车前进、后退、左转、右转、停止。

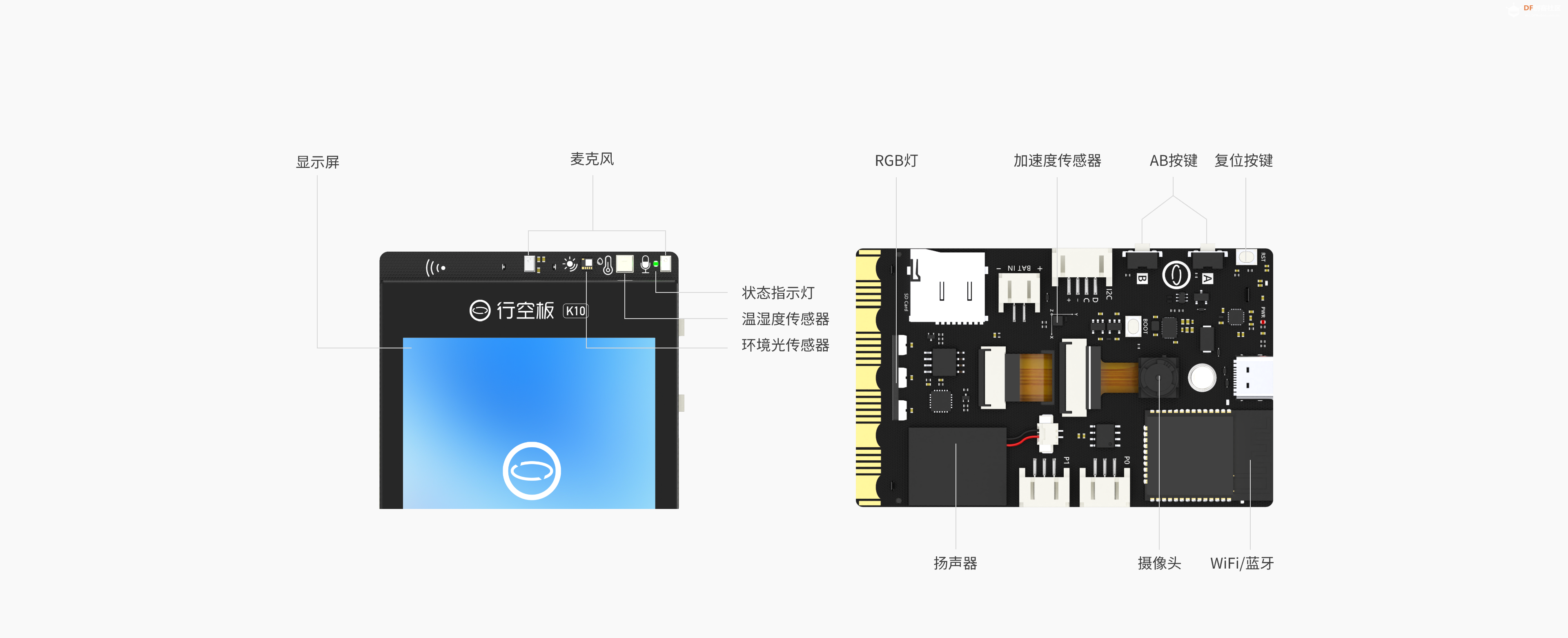

- 硬件方面:选用国产开源硬件行空板K10作为主控,集成电机驱动、TF卡存储、I2C总线等接口,体积小、功耗低、扩展性强;搭配专为教育场景设计的Huskylens 2 AI视觉传感器,内置人体姿态识别算法,无需复杂模型训练即可直接输出关键点数据,大幅降低中小学生的使用门槛。

- 软件方面:采用图形化编程平台,学生像拼积木一样把“AI感知→逻辑判断→运动控制”三大环节拼接起来,在10分钟内就能完成“手势→小车动作”的闭环,实现“人体即遥控器”的科幻体验。

【项目硬件】

1.HuskyLens 2 AI视觉传感器

2.行空板k10

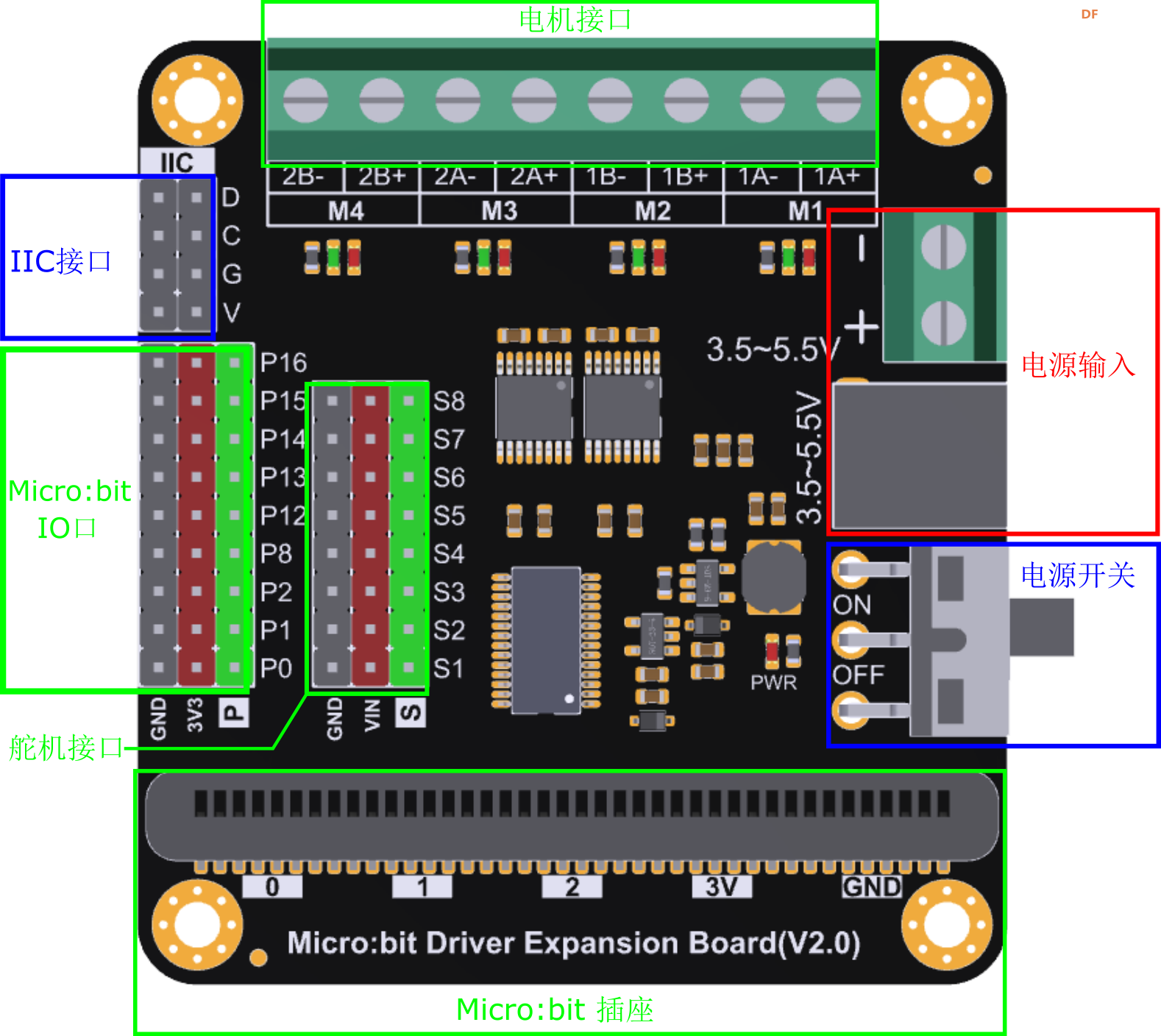

3.micro bit电机驱动扩展板

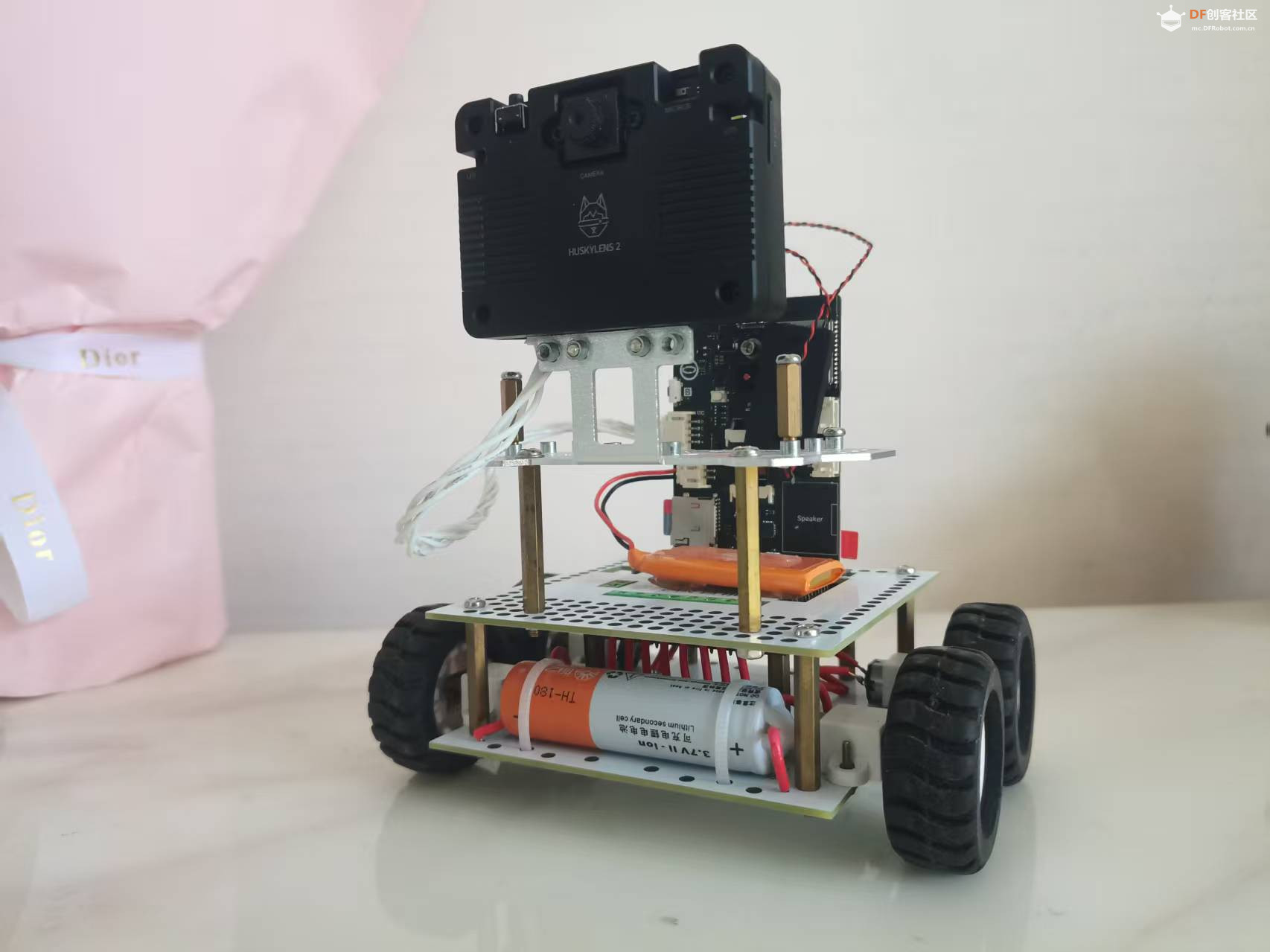

【硬件组装】

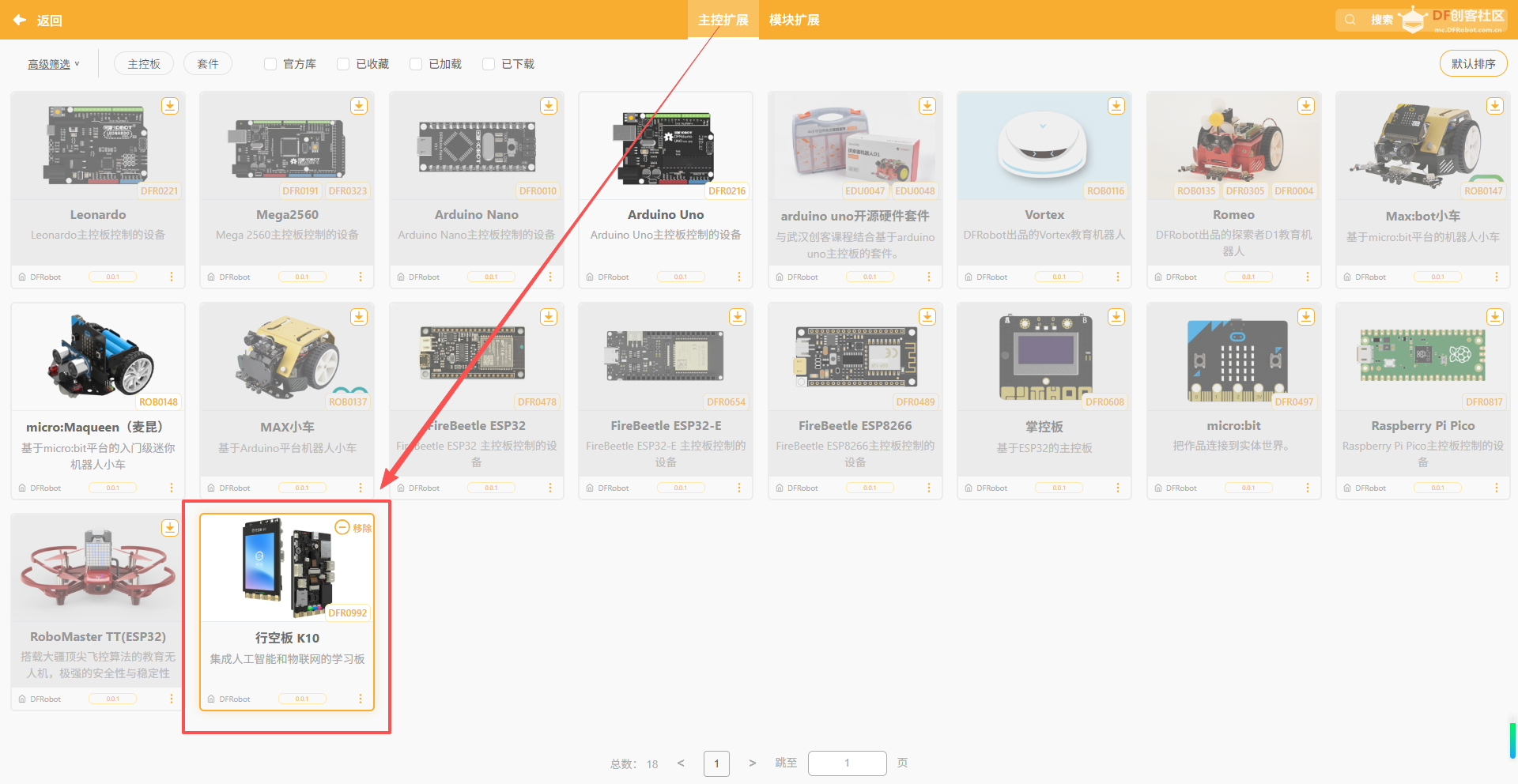

【Mind+扩展】

1.加载行空板k10主控

2.micro bit电机驱动扩展板、HuskyLens 2 AI视觉传感器

【程序代码】

1. 初始化部分

- 行空板K10主程序开始

- 定义前进

- 缓存显示TF卡图片 Logojpg 在x

- 将缓存内容显示/显示更新

- 以200)速度

- Huskylens 2 初始化I2C通讯直到成功

- Huskylens 2 切换算法到姿态识别

- 启动主程序,显示LOGO图片。

- 初始化Huskylens 2,设置为人体姿态识别模式。

- 设置电机速度为200(可能是PWM值)。

2. 主循环逻辑- 盾环执行

- 请求一次人体姿态数据存入结果

- 签,检测到人体?那么执行

- 进入主循环,不断读取Huskylens识别到的人体姿态数据。

- 如果检测到人体,才继续执行后续判断。

3. 动作判断逻辑(核心)

程序通过比较人体关键点的Y坐标(垂直方向)来判断动作:

- | 条件 | 动作 | 逻辑说明 |

- | ---------------- | --------- | ----------------------------- |

- | `左眼Y > 左腕Y` | **前进** | 左手举起与眼睛平齐 → 前进 |

- | `右眼Y > 右腕Y` | **右转** | 右手举起与眼睛平齐 → 右转 |

- | `左腕Y ≈ 左肩Y` | **左转** | 左手平举 → 左转 |

- | `右腕Y ≈ 右肩Y` | **右转** | 右手平举 → 右转 |

- | 无匹配 | **停止** | 无动作 → 停止 |

注:程序中用了“绝对值 < 20”来判断两个Y坐标是否“接近”,即误差范围内认为动作匹配。

4. 电机控制- 使用M1、M2、M3、M4四个电机。

- 通过正转/反转实现方向控制:

- 前进:所有电机正转

- 前进:所有电机反转

- 左转:M1、M2正转,M3、M4反转(差动转向)

- 右转:M1、M2反转,M3、M4正转

- 停止:所有电机停止

【演示视频】

|

沪公网安备31011502402448

沪公网安备31011502402448