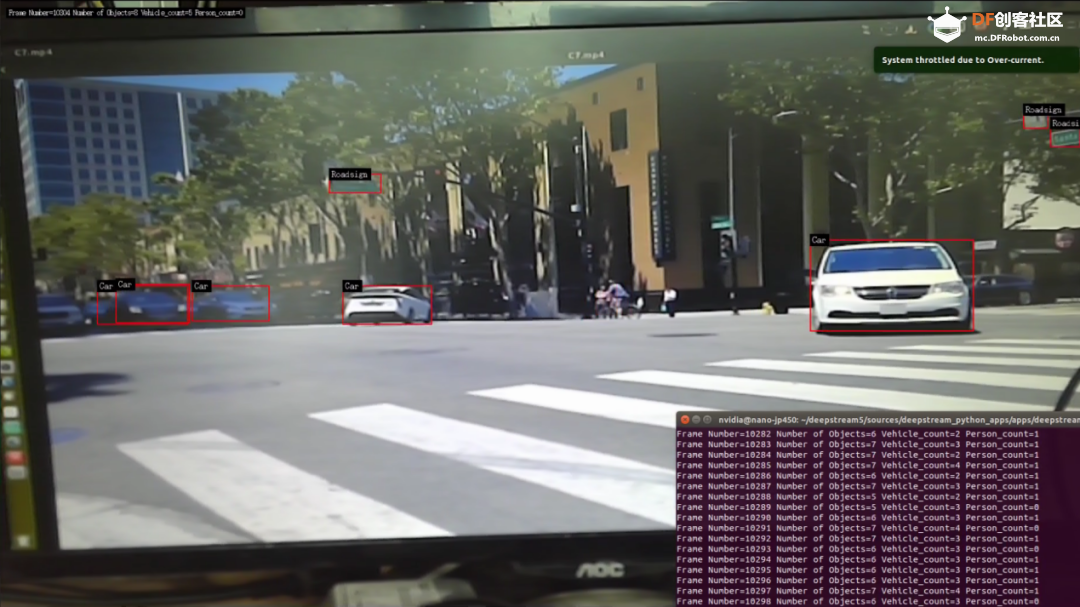

本文以上一期 Python 版的 deepstream-test1 deepstream-teat1-usbcam 与 deepstream-teat1-rtsp-out 中,分别将输入源 从视频文件变成 USB 摄像头 ,以及将输出 从显示屏变成 RTSP 视频流 。接下去同样从代码内容来看看这两个部分需要进行怎样的修改。文件路径: /sources/deepstream_python_apps/apps的deepstream-test1-usbcam/deepstream_test_1_usb.py 范例功能:将 deepstream-test1 的视频文件输入改成 USB 摄像头 插件流:v4l2src --> videoconvert--> nvvideoconvert --> nvstreammux --> nvinfer --> nvvideoconvert --> nvdsosd --> nvegltransform --> nveglglessink 将原本数据源插件从 filesrc 改成 v4l2src 将原本格式转换插件从 h264 相关的,改成符合 USB 摄像头原始数据格式相关的 source = Gst.ElementFactory.make("filesrc", "file-source")

h264parser = Gst.ElementFactory.make("h264parse", "h264-parser")

decoder = Gst.ElementFactory.make("nvv4l2decoder", "nvv4l2-decoder")

streammux = Gst.ElementFactory.make("nvstreammux", "Stream-muxer") 复制代码 source = Gst.ElementFactory.make("v4l2src","usb-cam-source")

caps_v4l2src = Gst.ElementFactory.make("capsfilter","v4l2src_caps")

vidconvsrc = Gst.ElementFactory.make("videoconvert","convertor_src1")

nvvidconvsrc=Gst.ElementFactory.make("nvvideoconvert","convertor_src2")

caps_vidconvsrc = Gst.ElementFactory.make("capsfilter","nvmm_caps")

streammux = Gst.ElementFactory.make("nvstreammux","Stream-muxer") 复制代码 caps_v4l2src.set_property('caps',Gst.Caps.from_string("video/x-raw, framerate=30/1"))

caps_vidconvsrc.set_property('caps', \ Gst.Caps.from_string("video/x-raw(memory:NVMM)"))

source.set_property('device',args[1])

。。。。

sink.set_property('sync',False) 复制代码 cd<deepstream< span="">根目录>/sources/deepstream_python_apps/app

cd deepstream-test1-usbcam

python3 deepstream_test_1_usb.py 复制代码 文件路径:/sources/deepstream_python_apps/apps的deepstream-test1-rtsp-out/deepstream_test1_rtsp_out.py 范例功能:将 deepstream-test1 的输出透过 RTSP 协议转向其他电脑 修改重点:在 nvdsosd 之后添加将格式转成符合 RSTP 协议的 H264 格式,主要如下: sudo apt update

sudo apt-get install libgstrtspserver-1.0-0 gstreamer1.0-rtsp

sudo apt-get install libgirepository1.0-dev

sudo apt-get install gobject-introspection gir1.2-gst-rtsp-server-1.0 复制代码 nvvidconv_postosd = Gst.ElementFactory.make("nvvideoconvert", "convertor_postosd")

# 创建caps过滤器

caps = Gst.ElementFactory.make("capsfilter", "filter")

caps.set_property("caps", Gst.Caps.from_string("video/x-raw(memory:NVMM), format=I420"))

# 根据输入参数选择使用的编码器,预设为H264

if codec == "H264":

encoder = Gst.ElementFactory.make("nvv4l2h264enc", "encoder")

elif codec == "H265":

encoder = Gst.ElementFactory.make("nvv4l2h265enc", "encoder")

encoder.set_property('bitrate', bitrate)

# 如果是在 Jetson 设备上,执行下面的设定

if is_aarch64():

encoder.set_property('preset-level', 1)

encoder.set_property('insert-sps-pps', 1)

encoder.set_property('bufapi-version', 1)

# 使有效负载将视频编码为RTP数据包

if codec == "H264":

rtppay = Gst.ElementFactory.make("rtph264pay", "rtppay")

elif codec == "H265":

rtppay = Gst.ElementFactory.make("rtph265pay", "rtppay")

# 建立 UDP 接收器

updsink_port_num = 5400

sink = Gst.ElementFactory.make("udpsink", "udpsink")

# 设定接收器的值

sink.set_property('host', '224.224.255.255')

sink.set_property('port', updsink_port_num)

sink.set_property('async', False)

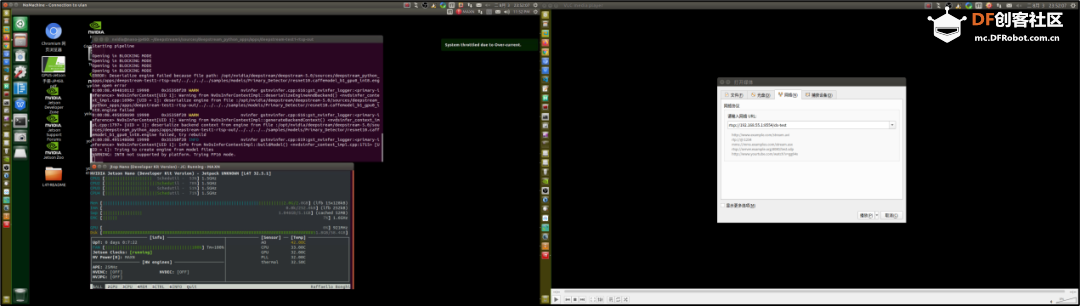

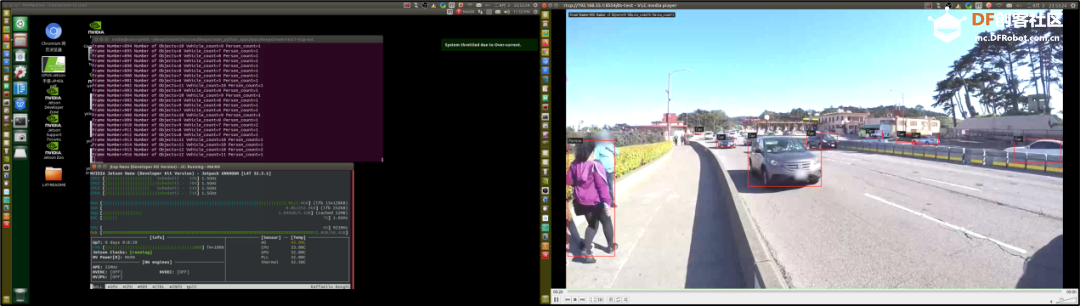

sink.set_property('sync', 1) 复制代码 https://github.com/GStreamer/gst-rtsp-server # Start streaming

rtsp_port_num = 8554 # 设定端口值

server = GstRtspServer.RTSPServer.new()

server.props.service = "%d" % rtsp_port_num

server.attach(None)

factory = GstRtspServer.RTSPMediaFactory.new()

factory.set_launch( "( udpsrc name=pay0 port=%d buffer-size=524288 caps="application/x-rtp, media=video, clock-rate=90000, encoding-name=(string)%s, payload=96 " )" % (updsink_port_num, codec))

factory.set_shared(True)

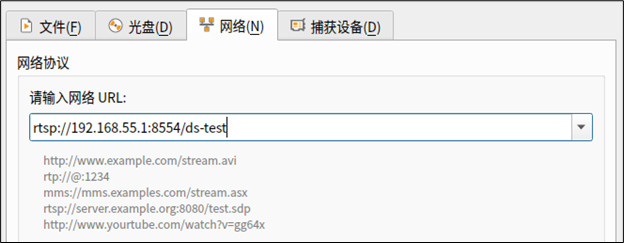

server.get_mount_points().add_factory("/ds-test", factory) # 设定加载点 复制代码 rtsp://192.168.55.1:8554/ds-test ”(如下图)# 在DeepStream设备(如Jetson Nano 2GB)

cd<deepstream< span="">根目录>/sources/deepstream_python_apps/apps

cd deepstream-test1-rtsp-out

ln -s ../../../../samples/streams/sample_720p.h264 sample_720.h264

python3 deepstream_test_1_usb.py -i sample_720.h264 复制代码

沪公网安备31011502402448

沪公网安备31011502402448